ChatGPTやStable Diffusionなど、その急激な進化が注目を集めるジェネレーティブAI。現在サンフランシスコで開催中のゲーム開発者向けイベント“ゲーム・デベロッパーズ・カンファレンス”でも、その成果をゲーム開発に応用するさまざまな試みが模索されている。

NPCの会話用原稿テキストから音声と身振り手振りのモーションを生成

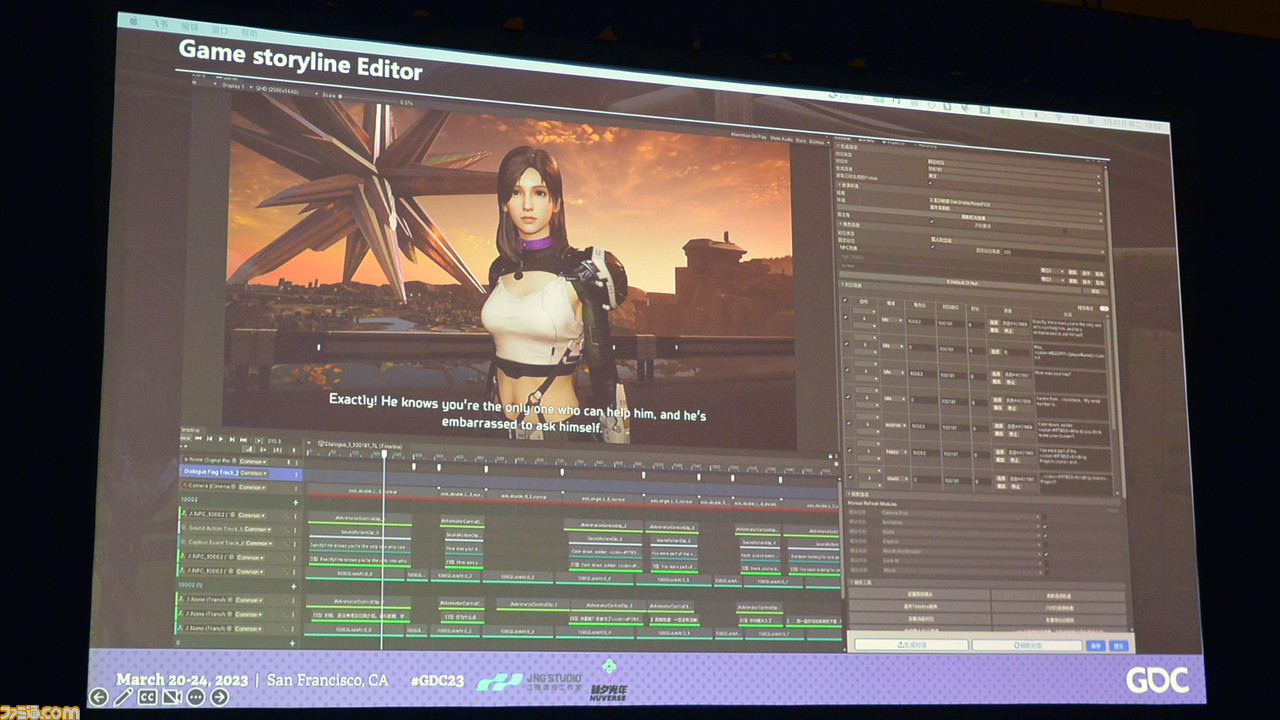

NUVERSEのDao Si氏による講演では、同社のモバイル/PC向け新作『アース: リバイバル』のNPCの会話用原稿からAIを通じて音声データとキャラの身振り手振りのモーションを生成するという事例が報告された。

ここでポイントとして指摘しておきたいのが、ここで紹介された仕組みは「AIでリアルタイムに反応するNPCのゲームを作った」という段階のものでも、「テキストの指示からAIで全部を作る」といった性質のものでもないということだ(ただし人間と音声を通じてアバターが会話する実験映像は流れた)。

現状ではあくまで、大型のRPGタイトルの中で大量に必要とされるちょっとしたNPCたちの会話シーン用素材の量産を原稿テキストから高品質に自動生成し、その分の労力をメイン系のキャラの開発に割くという非常に地道な運用の話なのである。

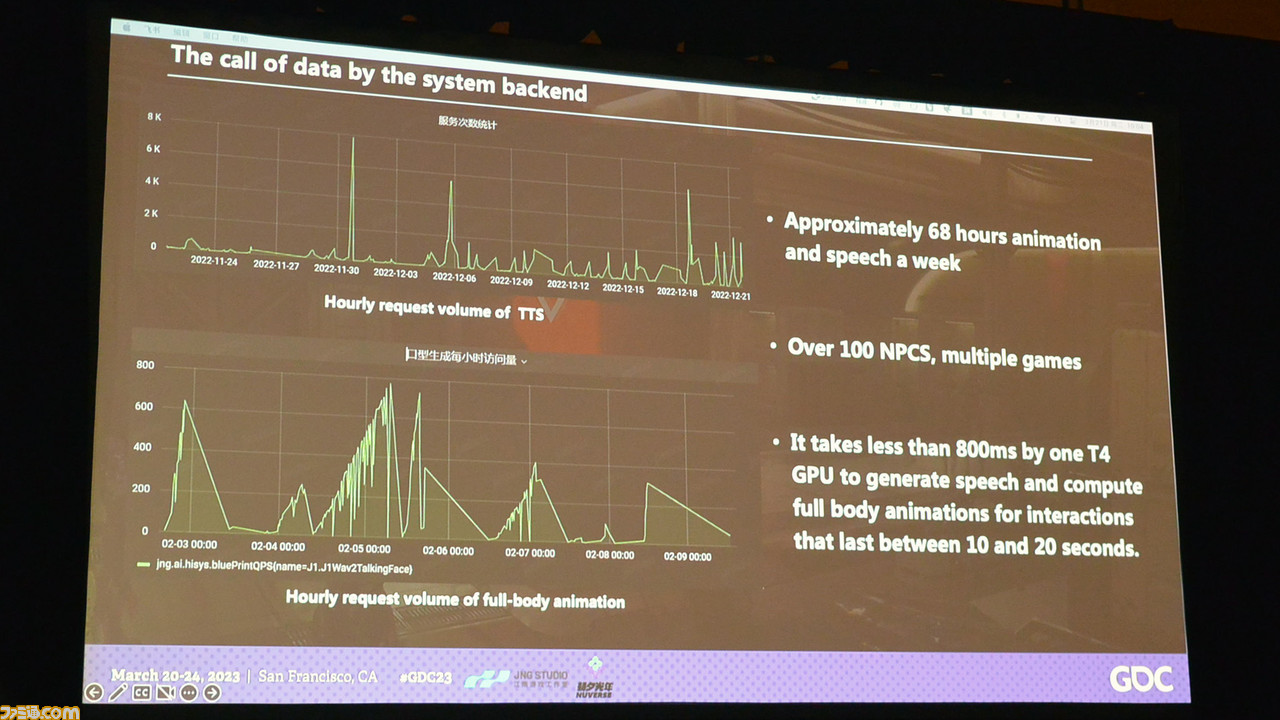

しかしその生産性は非常に高く、1週間のデータとして複数タイトルにまたがるNPC100人以上のデータを合計68時間分の音声・モーションデータを生成しているとのこと。処理はNVIDIA T4のGPUで行っており、10秒から20秒のシーンの処理はT4一基で800ミリ秒以下で行えるという。

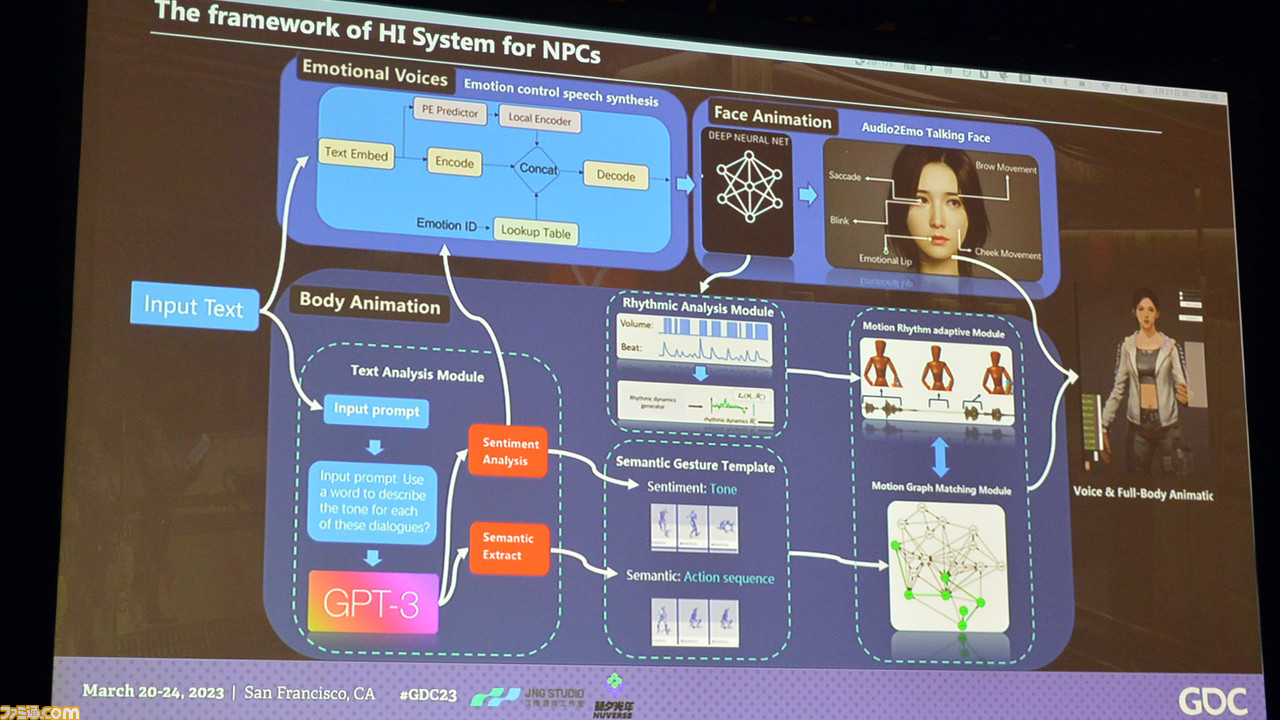

“Hi System”と呼ばれるこのシステムの仕組みは、いくつかのモジュールから成り立っている。

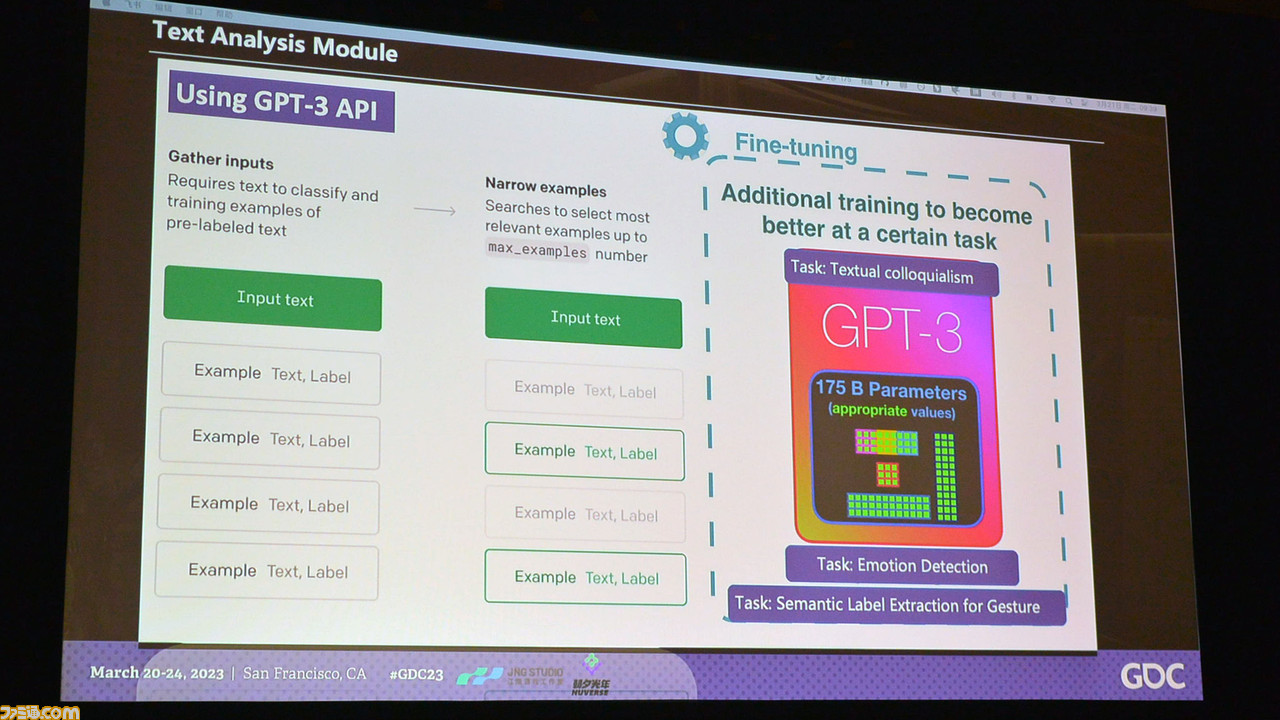

まずは原稿テキストを解析するモジュール。これは会話のトーンや意味・感情などをGPT-3を使って分析し、その内容を他のモジュールに渡していく。

次に登場するのがテキストから音声を生成するモジュールで、テキスト分析によって導かれた感情タグ(30種類以上)を参照しつつキャラの音声を合成する。

3番めは表情アニメーションを担うモジュールで、ここではディープラーニングモデルに基づいて元原稿と生成された音声、そして感情タグに従って自然な表情を作り出す。

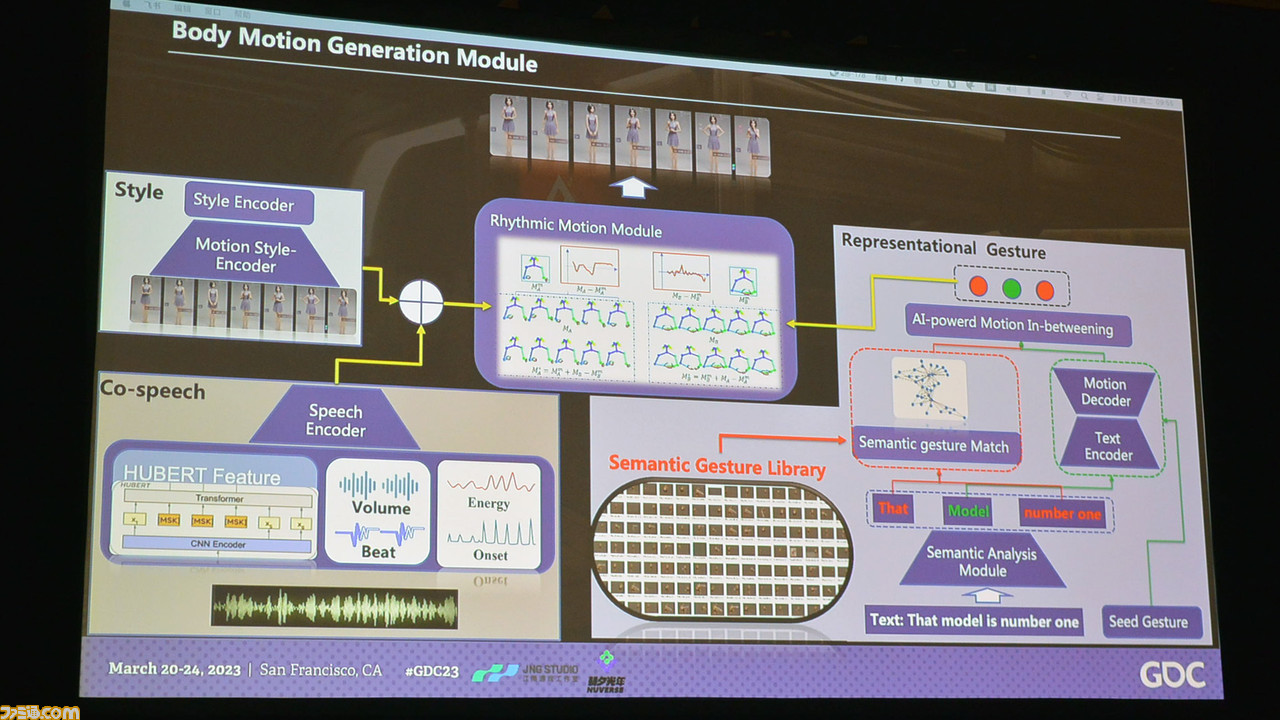

4番目は身振りを担うモジュール。テキスト分析にマッチするジェスチャー(意味分析は200以上のタグで分類)や表情アニメーションに沿った会話のリズムに基づいて身振りのモーションを生成。

こうしてこれらのモジュールが作り出してきたデータが揃うと完成となる。

全体として各モジュールが相互に連携しながら動くその内容は「随分と大掛かりなものだな」と感じたが、複数タイトルでの運用や多言語対応が可能なシステムとなっていたので思わず納得。

デモ映像では中国語だけでなく英語や日本語でも喋っている様子が見られた。もちろんローカライズテキストの用意や感情タグの一致などのチェック機構は必要だろうが、逆にそこさえしっかりやれば各対応言語のボイスだけでなく、その音声に一致したモーションデータまで揃うというのは大きい。

NPCの雰囲気の会話のバリエーションをAIが提案するシステム

ユービーアイソフトがGDCで公表したライター支援システム“ゴーストライター”もまた、ジェネレ―ティブAIを活用してマイナーなコンテンツに割く時間を削減し、もっと主要なシーンに集中しようという試みだ。

このAIが扱うのは、“Barks”(恐らく露店などの“呼び込み”の意味から来ている)と呼ばれるゲーム中の通行人などが発するちょっとしたセリフ。世界の雰囲気演出やプレイ体験の向上のためには必要な要素だが、この手のセリフはゲームのストーリーそのものにはあまり影響しない割に、プレイ中に同じものばかり聞こえないように何パターンか必要とされる。

そこでこのシステムでは、ライティング担当がオリジナルの原稿を仕上げたらAIが複数の追加パターンを提案してくる。担当はそれを承認したりちょっといじったり、再出力させたりして数を揃えられる……という流れになっている。

AI生成とAIアシストでUGC開発を加速する取り組み

一方で、オンラインゲームプラットフォーム『Roblox』の試みは、一般の人が「ジェネレ―ティブAIでゲーム作りする未来」とイメージするものに近いかもしれない。

『Roblox』が発表した一連のAI関連の技術は、Roblox自社の開発者向けではなく、UGC(ユーザー作成によるコンテンツ)プラットフォームとしての『Roblox』で一般ユーザーの開発を助けるもの。「雨を降らせて」とか「クルマを浮かせて」といったテキスト指示で自分の作品世界を操作したり、「ピンクの溶岩」といったテキスト指示でマテリアル(素材)を生成することもできる。

またそれだけでなく、開発ツール“Roblox Studio”にはGitHub CopilotのようなAIによるコード支援機能もつく。コード支援機能のための学習モデルはマーケットプレイスで配布されている無料素材を使ってチューニングされており、非公開のデータなどは使用していないとのこと。

Generative AI on #ROBLOX examples from #GDC2023 https://t.co/dPFOLX7Nd9

— Morgan McGuire (@CasualEffects)

2023-03-21 06:40:43

AI Code Assist on Roblox Studio, now free and live as of 9am this morning.

In this example, the programmer typed… https://t.co/vCSEkIKn77

— Morgan McGuire (@CasualEffects)

2023-03-21 06:22:08

Just released on #Roblox: AI Material Generator!

Create full PBR materials directly from text prompts. You can con… https://t.co/zoG797GNK2

— Morgan McGuire (@CasualEffects)

2023-03-21 06:25:16