2021年7月19日~23日(アメリカ現地時間)に、今年度はオンラインでの開催となった世界最大級のゲーム開発者カンファレンスイベント"ゲーム・デベロッパーズ・カンファレンス 2021"(以下、"GDC 2021")。

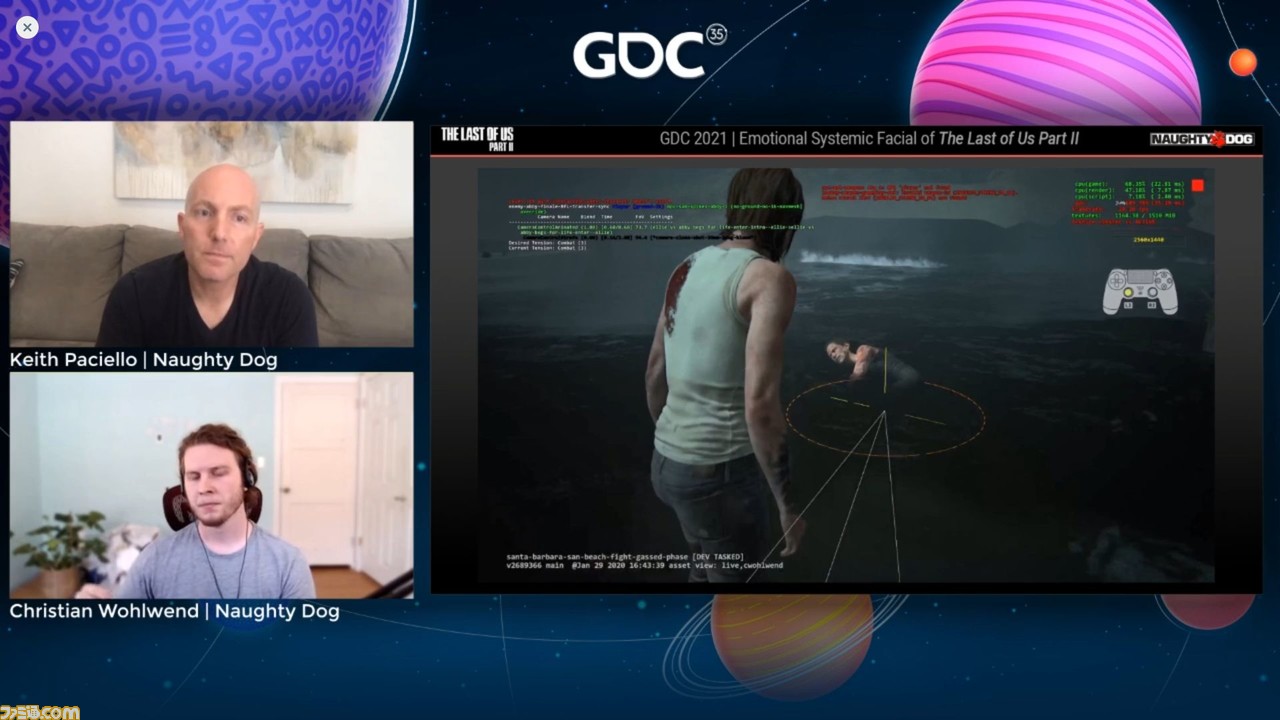

2021年7月22日(日本時間では23日)には、『The Last of Us Part II(ザ・ラスト・オブ・アス パート2)』のカンファレンス“Emotional Systemic Facial of 'Last of Us Part II'”が行われた。

ここで語られたのは、本作に搭載されたフェイシャルシステムの開発(概念、側面、実装)について。担当したのはノーティードッグに所属するアニメーターのKeith Paciello氏と、ゲームデザイナーのChristian Wohlwend氏だ。

なお、最後の項目はゲーム終盤の展開に関するネタバレを含むので、ゲームをまだクリアーしていない方は、注意してほしい。

『The Last of Us Part II』のキャラクターの表情が見せる、さまざまな感情

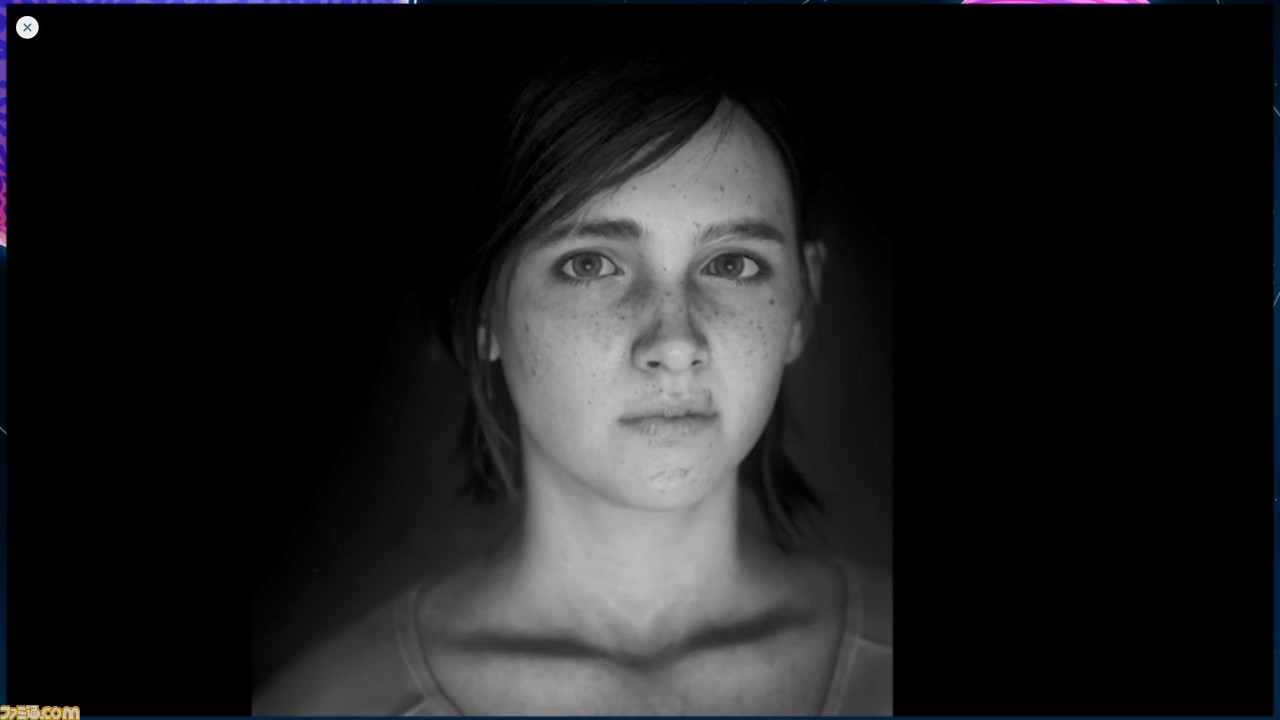

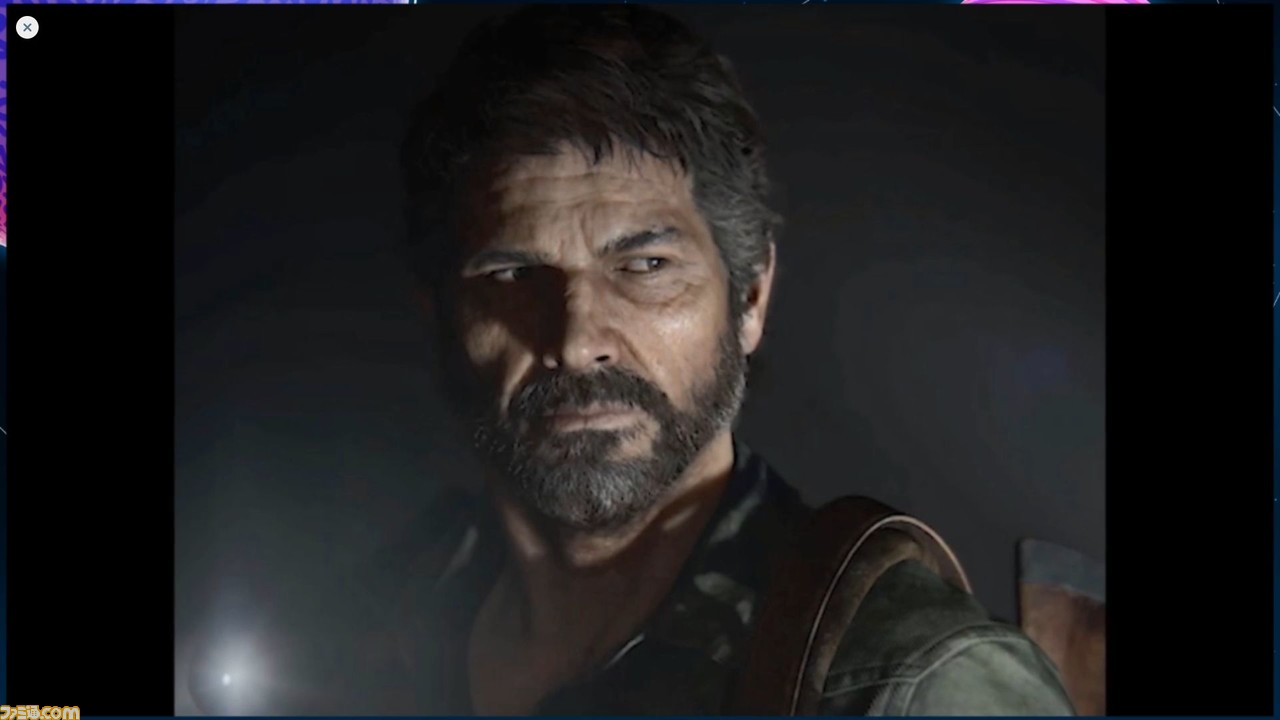

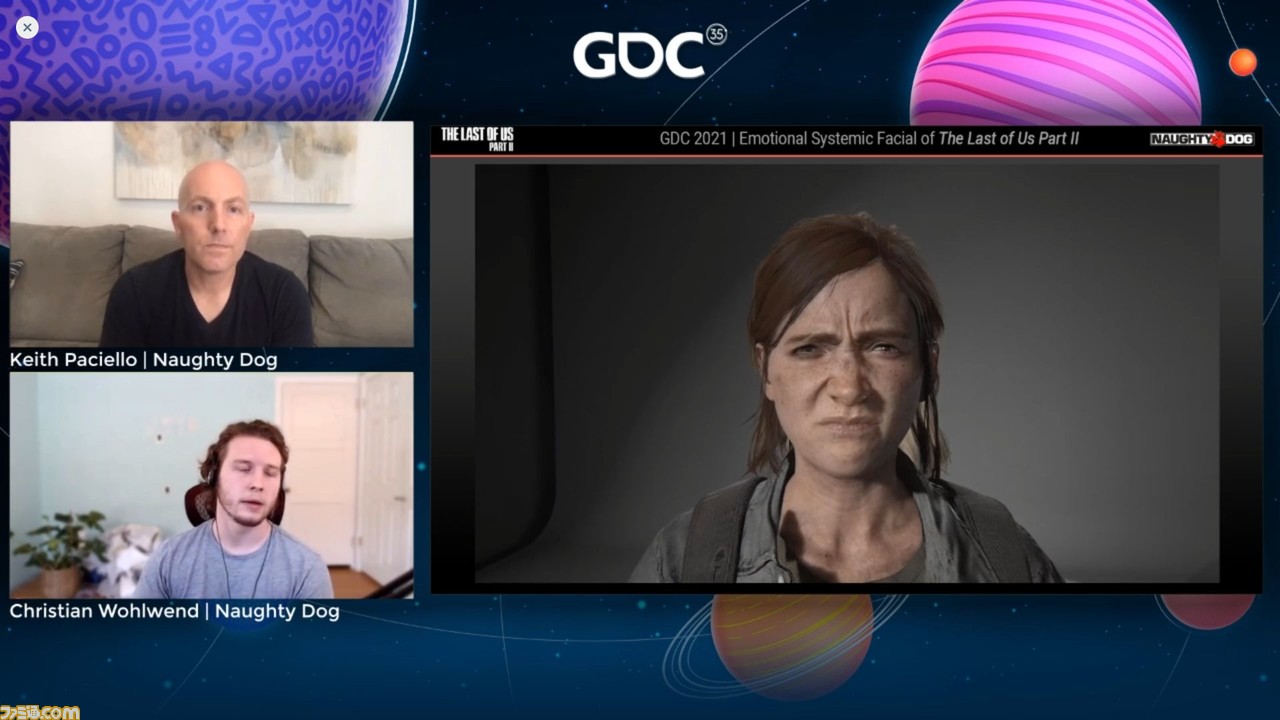

カンファレンスは、さまざまな表情を見せる『The Last of Us Part II』(以下『ラスアス2』)の主要キャラクターたちの、画像及びインゲームの映像から始まった。

続いて、Keith氏が語り始める。これらはフォトモードの画像のモンタージュと、ゲームの映像を使用したビデオクリップだが、ここでキャラクターたちが見せる表情は、ゲームに実装したフェイシャルシステムを使い、ゲーム内でリアルタイムに実行されているものだという。フォトモードは、フェイシャルシステムが可能にする一瞬の微妙な表情変化や、その幅広さを説明する際に役立つのだとか。

『アンチャーテッド』シリーズでは、直近の『アンチャーテッド 海賊王と最後の秘宝』と『アンチャーテッド 古代神の秘宝』に、同様の技術が導入されている。何年ものあいだ、ノーティードッグが開発したゲームのレビューを見てきたが、ノーティードッグの技術に対して、「これ以上によいものにすることなんて可能なのか?」と言う人はつねに存在するという。

多くのゲームにおいてキャラクターの顔はプレイ中も見えるが、表情豊かなムービーシーンと違って、ふつうはニュートラル、あるいは空虚な表情をしている。一方でノーティードッグ作品のキャラクターの顔はリアリティーのある造形をしているものが多かったが、そのゲームプレイ中の表情は「もっとよく出来るはずだ」と感じていたのだとか。

ノーティードッグのゲームは感情的なストーリービート(ストーリーの最小要素)に溢れている。それはムービーシーンだけでなく、ゲームプレイ全体に言えることだ。つねに、もっと力を入れられないか? 誰かが全力を注ぐことで、さらによいものになるのでは? と考えられていた。

Keith氏は映画界のアニメーション手法や演出術を学び、それらのキーアートを手掛けてきた経験から、『ラスアス2』のそうした課題に取り組む役割が与えられたという。

ゲームプレイを考慮したときの開発チームの課題は、「どうしたら我々が求める感情的な顔のパフォーマンスを目指しつつ、25時間ほど掛かるゲームプレイを完全にカバーできるか?」ということだった。ゲーム内キャラクターたちはフェイシャルリグ(CGキャラクターの顔に仕込まれている、表情筋や骨格)を持っている。その知識を得るだけでも、何らかの改善が可能なのではないかと思ったという。

ではどのように実行すべきか? 考えたのは、“ニュートラル音素セット”と呼ばれる既存の口の形を動かすのに用いられている手法を利用すること。もうひとつはシンプルに、まったく新しい手法が使えないかということだった。

まずは、これまでのゲームではどのようにして口の動きが制御されてきたのか、改めて学ぶことになった。すると、過去作で使われていた“ニュートラル音素セット”はたったひとつだったことがわかった。それ以前のゲームでもキャラクターにはニュートラル、不安、そして戦闘時という3つの異なる態度があった。もしキャラクターが戦闘中に話す場合、緊張した表情からニュートラルに戻ってセリフを言い、緊張状態に戻る。『ラスアス2』でもこの3形態の基本は変わっていない。

ダイアログ・デザイナーのトップであるMike Hourihan氏に連絡して、複数の“ニュートラル音素セット”を同時に扱うことは可能かどうかを聞いた。彼の答えは“イエス”で、プログラミングコード側で必要なものを追加する方法を説明してくれた。Mike氏が技術サイドのスタッフも動員してくれたので、とても大きな助けになったという。

Mike氏はリードプログラマーのひとりであるTravis Mcintosh氏のところへKeith氏を連れていき、技術的にどんなことが可能であるかについて話を始めた。彼らの話を聞き、Keith氏は自分たちが持つ感情を、どのようにゲーム内で表現すればよいのかと思考を巡らせたという。

堅固な基礎からのスタート

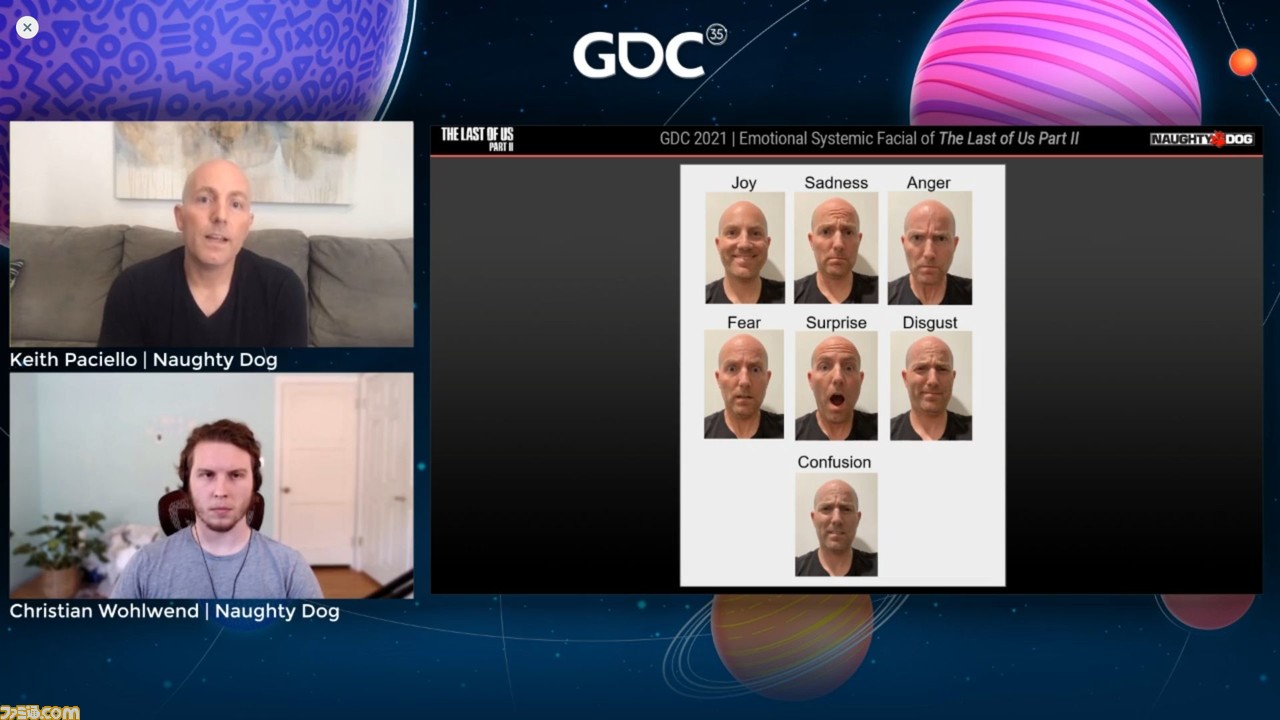

何かを始めるときには、堅固な基礎をしっかり作るのを好むというKeith氏。最初に感情について深く思案することは、直面している課題の解決においてはつねに近道になると考えていた。いくつか調査をした結果、7つの普遍的に認識可能な感情に行き着いたという。

この普遍的に認識可能、ということが、Keith氏はすごくいいと思った。ノーティードッグのゲームは世界中のさまざまな言語でプレイされているが、この7つを大事にすれば、言語を介さずとも世界中の人々とコミュニケーションを取ることも可能だと思ったからだ。

7つの普遍的に認識可能な感情とは何か? それは喜び、悲しみ、怒り、恐れ、驚き、嫌悪、そして混乱だ。この7つの感情を司る表情で、キャラクターの表現をカバーするというアイデアを、Keith氏は、かなりよいスタートだと感じた。これは広い用途に用いられるべきセットであり、複雑になり過ぎてはいないのも重要なのだという。

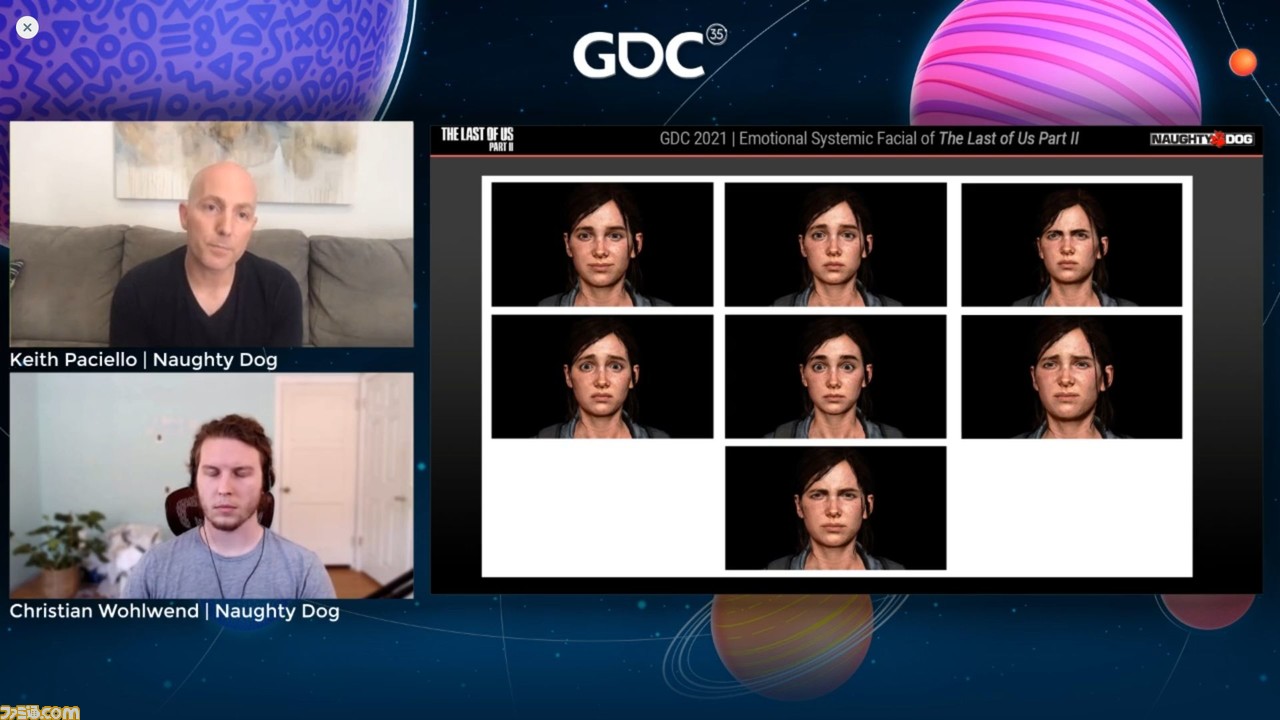

つぎの画像は、プロダクション初期段階での7つの感情を表すエリーの顔。彼女の、前作『The Last of Us』(以下『ラスアス』)から年齢を重ねた新しい外見に、新しいフェイシャルリグが取り入れられている。荒削りではあるが、ここに表現された感情には十分な可能性があると感じ、自分のアイデアを売り込む際の勝算を感じた。

インゲーム・フェイシャルの目的は、ゲームのナラティブ(物語性)にぴったり合う、幅広い感情を表現することだった。同時に、できるだけ複数の感情の繫がりを自然なものにする必要がある。フェイシャルシステム全体のゴールは、堅牢なモジュラー形式を維持しつつ、同時にメモリのコストを抑えることだった。

このアイデアを売り込んだ後、エリーがこれらの表情でゲーム内を動き回るのは、少し大げさすぎると感じた。そこで7つの感情のひとつひとつをトーンダウンしたところ、より地に足の着いた、作ろうとしている世界にマッチするものになった。トーンダウンされてもひと目で感情が認識できるバランスが理想だった。また、口は自動リップフラップという機能を使う際のことを考えて、基本は閉じているように調整した。これについては後述する。

とてもよいスタート地点にはなったが、これらのキーポーズは、パズルのほんの一部に過ぎなかった。それぞれの感情は、合致する“音素セット”とペアにする必要があった。

では、“音素セット”とは何か? ここからは、Christian氏が話を引き継いだ。“音素セット”とは永続的に区別されるサウンドの単位で、別々の単語どうしを相互に区別するために使用するものだという。本質的には私たちが言語として理解するために自然に聞き取っている、ちょっとした区別のことを指しているとのこと。

Christian氏いわく、このセッションで慣れてほしいもうひとつの重要な概念は“口形素”というもので、これはビジュアル側で音素と対等の立場にあるものだという。口形素は音素と完全にオーバーラップはしないが、口形素の中には似たような音素を使うものもある。これはCGでキャラクターを描くときの代表的な概念であり、アニメーションでは長く使われてきたものだ。

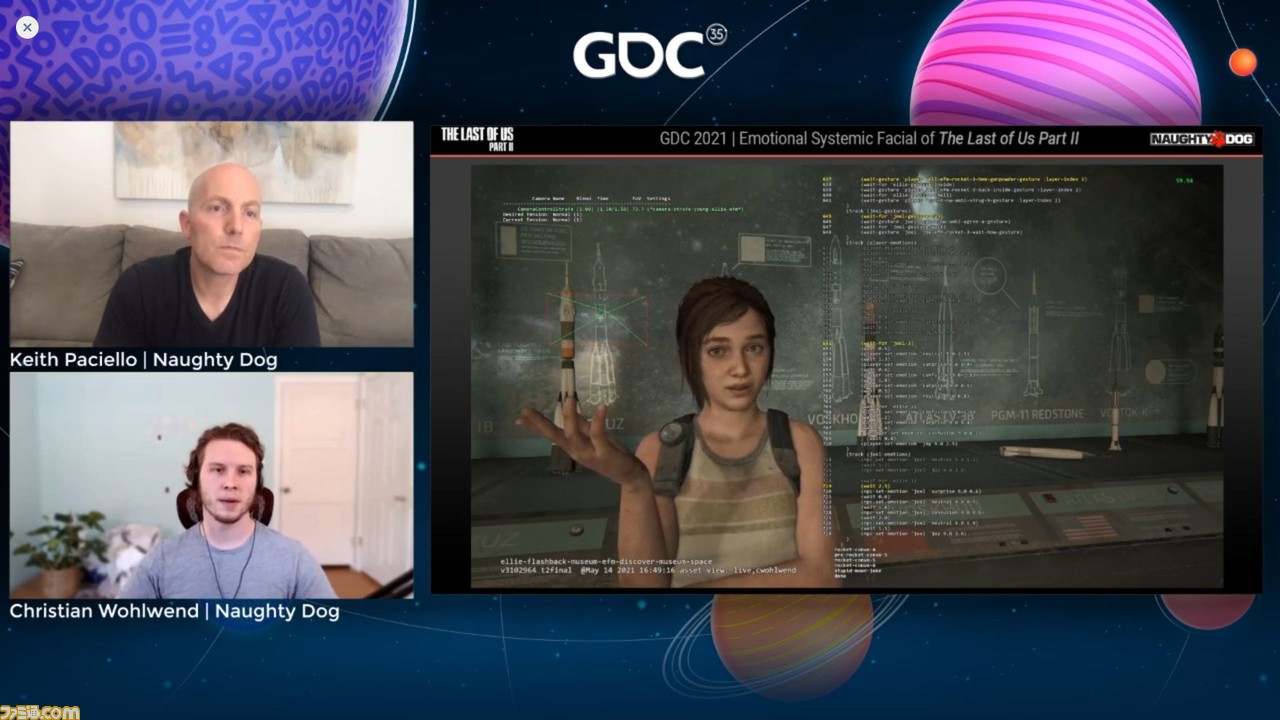

使用する数はスタジオによって異なっており、クラシックなディズニー・アニメーションは12種類の特定の口形素をキャラクターの表情に使っている。対してChristian氏たちの技術では、40種類を使用しているという。下の画像はエリーにさまざまな表情をさせる動画が流れている様子なのだが、ここでは音素セットのループがあり、40種類すべてのポーズを再生している。

この40という数値はいくつの音素が分解されているかということと、1対1の相関関係にある。このために、サードパーティーのツールを使用して分析をしており、すべての音に対して後処理を行う。このデータをゲーム内で再生し、分解した音素を1対1で音素セットから口形素へと関連付ける。

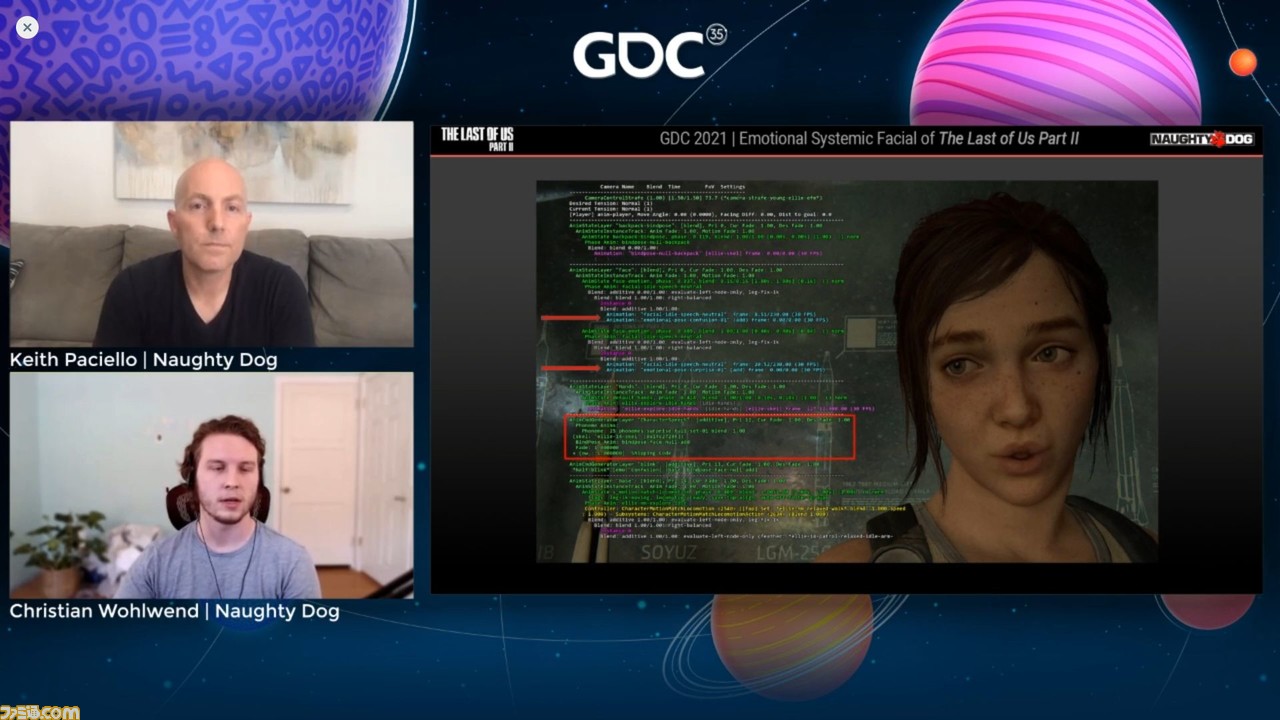

ゲーム内のいくつかの例を見てみよう。これは博物館のシーンでの過去のエリーで、ジョエルとロケットについて会話している。コードには、ふたつの異なる感情が同時に進行していることが現れているという。赤で囲われた部分には、実際の音素の内訳が書かれているとのこと。これらがエリーの顔の形状を制御しているのだ。

もうひとつの例で、いくつかの機能を紹介。こちらもふたつの感情が進行しているが、実際にはこの瞬間からは6つもの異なる音素が分解されている。技術者はエリーを制御するために3つの異なるアニメーションに関するフレームを使っている。ここでは単に音素セットから個々のフレーム間でブレンドしているのではなく、3つをまとめてブレンドしているようなものだ。これによって、複数の音素セットが組み合わされ、40フレームのうちのひとつだけを使うよりずっとダイナミックなものにできる。

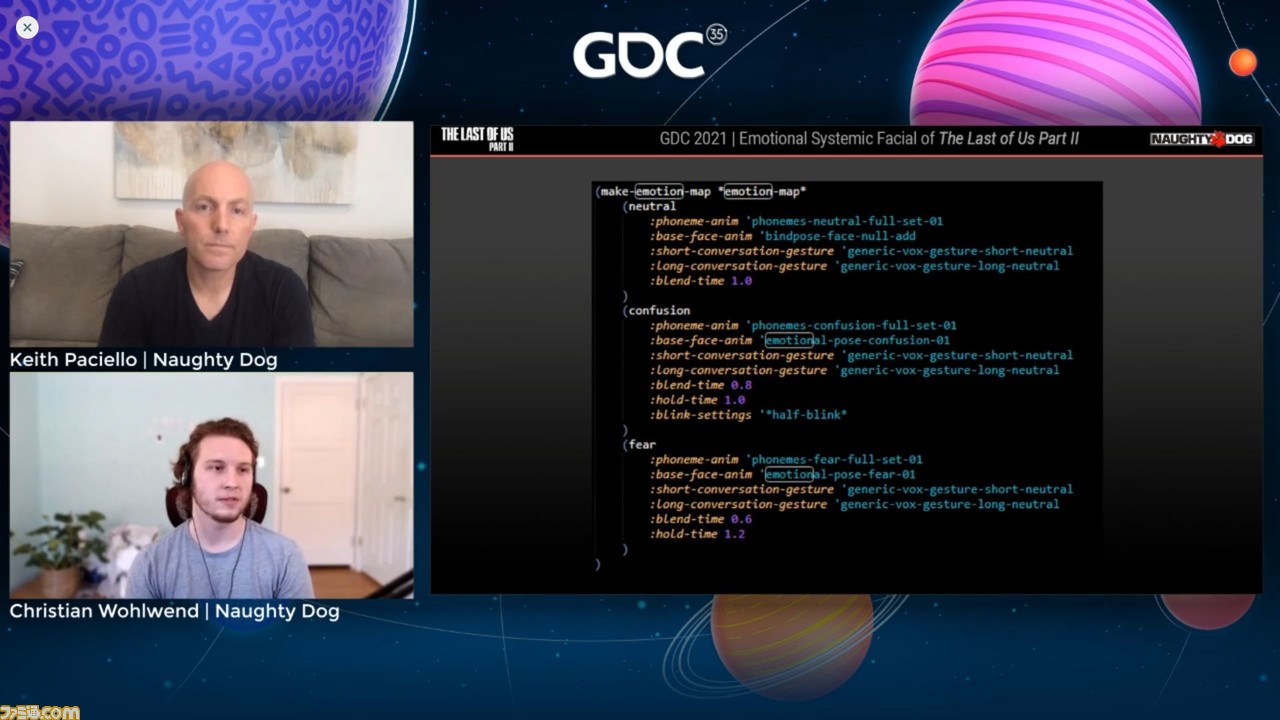

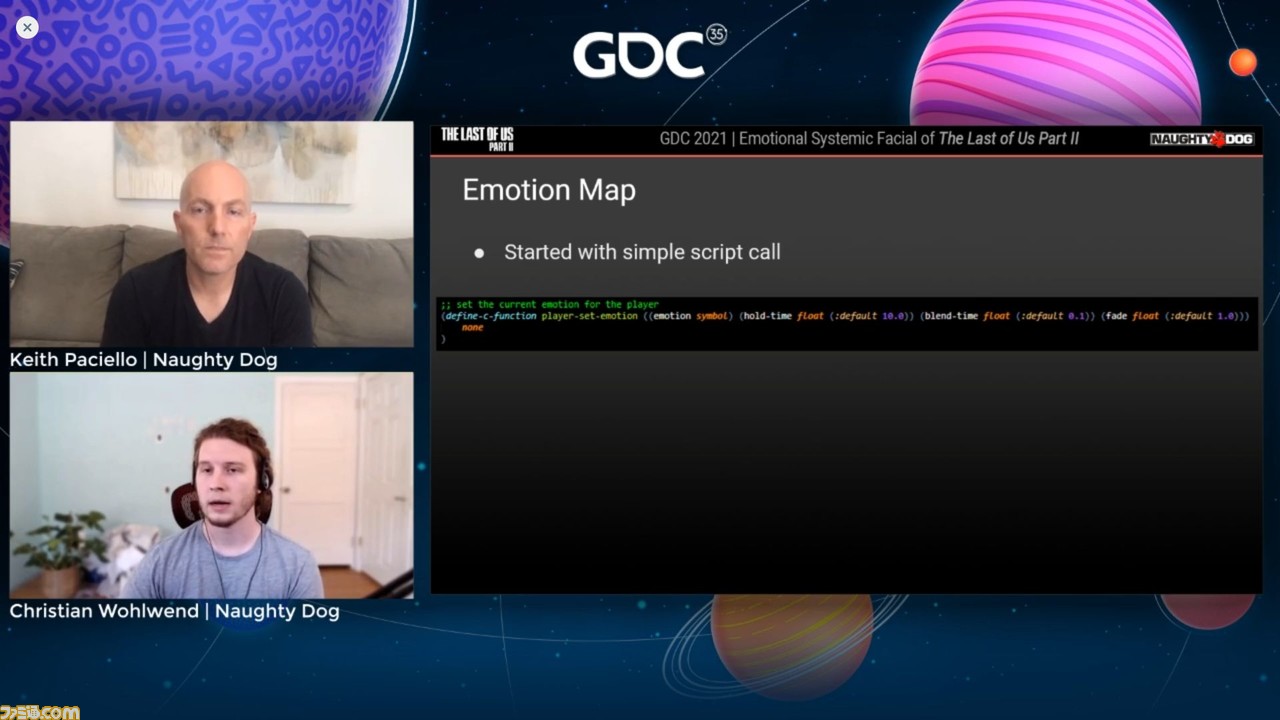

ここからは実際に、どのようにゲームへと感情の概念を取り込んでいくかについて、“感情マップ”を用いて説明する。多くの感情を取り入れるためには、まずそれらを定義し、作成したアセットを使って関連付ける必要があるという。キャラクターの感情を定義するコンセプトはいたってシンプルで“プレイヤーの行動が感情に反映されること”だとか。そしてそれは、スクリプトによって制御できるようにしなければならない。

キャラクターの感情を設定するときは、「プレイヤーがどんな感情で遊ぶか?」、「ホールドタイム、ブレンドタイムはどれくらいにすべきか?」、「フェード率はどれくらいにすべきか?」といったことを決めるという。この時点でChristian氏たちはキャラクターのさまざまな感情を循環させることができ、とてもシンプルな反復空間で作業を進めることができた。

システムの表現の幅を広げる

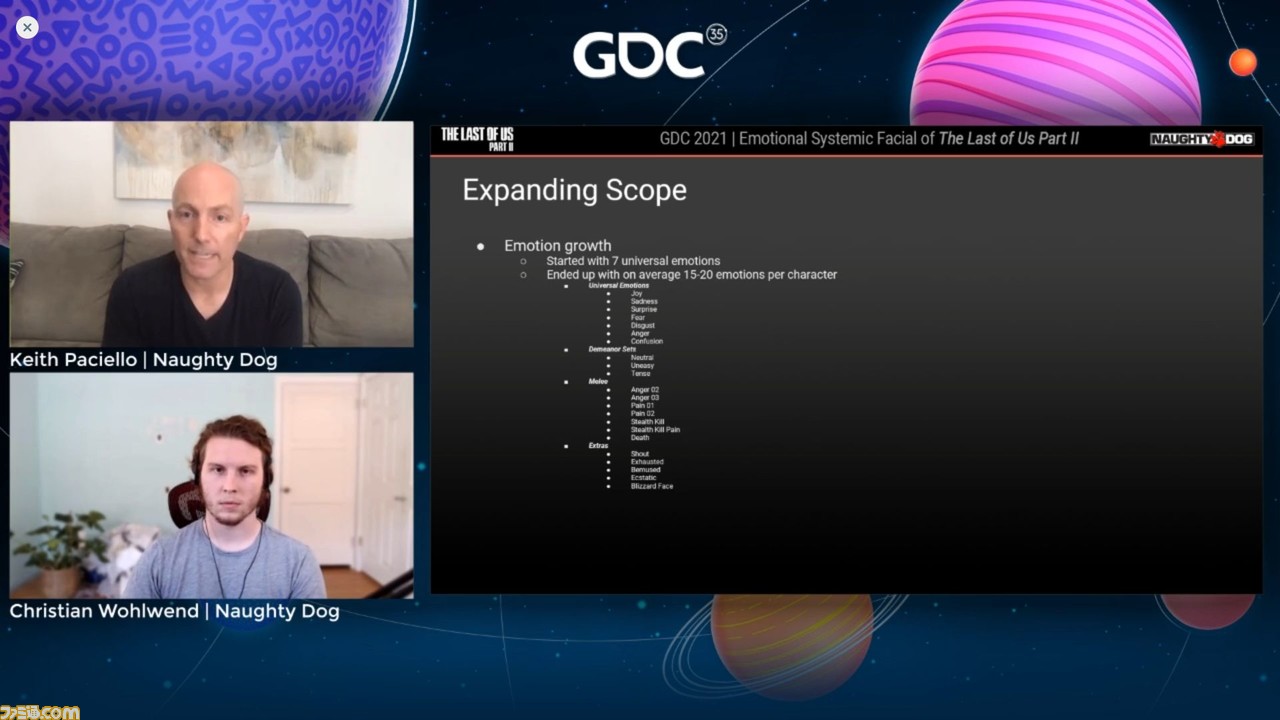

ここからは、再びKeith氏が語り始める。基礎が作れたので、さっそく感情の範囲、そしてフェイシャルシステムにサポートされているキャラクターの範囲を広げる作業に取り掛かった。感情の範囲を広げるとなると、普遍的な7つの感情は、ある程度キャラクターの感情の精度を上げたにすぎなかったという。ゲーム内で確認して明らかになったのは、キャラクターを表現するためには、まだ必要な何かが欠けているということだった。

その後、ひとりのキャラクターで平均15〜20種類の感情を設定し、サブグループに振り分けていった。前述の通り、7つの普遍的感情があり、キャラクターにはニュートラル、不安、戦闘の3つの態度がある。これらの感情的な音素セットを作ることは容易だった。下の画像は、それらの感情をキャラクターの状態に紐付けるものだ。

刃物や鈍器で戦うメレー(近接戦闘)では、Anger 02とAnger 03のレベルの感情が示されている点に注目してほしい。すべての基本感情は“01”と設定され、Joy 01、Sadness 01、Fear 01というようになっている。01は対話といったシチュエーションのためのもので、02、03と明確に感情が高まっていることを示す。

当初はすべてのキャラクターに感情の度合いを01~03まで設定することを考えていたが、メモリカウント、メモリフットプリントの問題でそれはできなかった。しかし0~1までの値を指定して感情を設定することはできたので、必要があれば感情の強さを調整する方法はあったのだとか。

シナリオライターから求められ、特殊な感情を設定したこともあったという。いくつかの端役のキャラクターには特別に叫び、疲労などの感情が必要だった。また、Ecstatic(夢中)という感情は、幼いエリーが博物館で恐竜を見たときだけのために作られたものだ。そしてBlizzard Face(凍える顔)は名前の通りだが、ゲーム終盤でアビーが燃える建物の中で顔を覆うところなど、想定にはなかった場面でも使われたという。

これらによって、下の画像のエリーの表情の違いからわかるように、微妙なものから極端なもの、そしてその間のものまで、キャラクターに多彩な感情の幅を持たせることができるようになった。

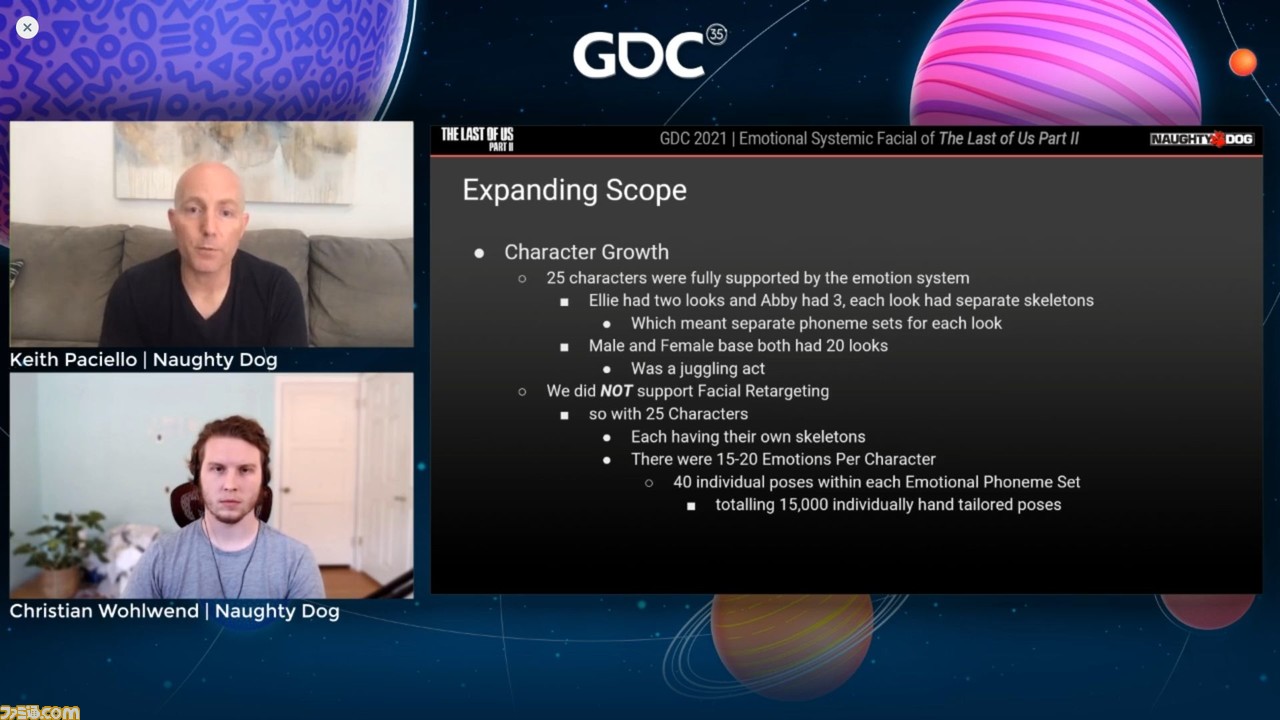

これらは、まずエリーだけに焦点を当てて適用されたが、すぐにゲームのキャラクターのうち25人をこの技術でサポートするという決断にいたったという。これはストーリーに関わるほとんどのキャラクターを指している。

この中にはもちろんエリーとアビーがいる。ふたりの名前を挙げたのは、エリーが幼いころと現在というふたつ、アビーは幼いころ、現在、そしてサンタバーバラと3つの外観を持っているからだという。それぞれの外観は個別の骨格を持っているので、音素セットをポートする際に、ひとつのサイズで間に合うというわけではなく、それぞれに最適な音素セットは調整する必要があった。

男性、女性のベースとなる外見はそれぞれ20種類があったので、この物量をどうにかするのも新たな挑戦となった。ベースとなる男性の外観は、ひとつポーズを変えるとほかの19の外観にも影響を与えた。各音素セットには40のポーズがあるので、これを調整するのはかなりたいへんな作業だった。

Keith氏は、リード・テクニカルディレクターのWasim Khan氏に本当に感謝していると述べた。彼のチームがこれらキャラクター、とくに非常に多くの外観を持つ女性と男性のベースにおけるフェイシャルシステムをサポートしてくれた。これだけで大規模な作業だったと言えるとのこと。

アセット作成の範囲はかなり広くなった。サポートする25のキャラクターはそれぞれ個別の骨格を持ち、ひとりのキャラクターは15〜20の感情を持ち、対応する感情の音素セットを持っているのだ。感情の音素セットごとに40の個別ポーズがあるので、合計15000の手作りのポーズがあるということになる。これはたいへんな作業量だったが、他方ではキャラクターごとの感情の忠実度を強力にコントロールできるということだった。また、アセットができればスクリプトで容易に実装することができた。

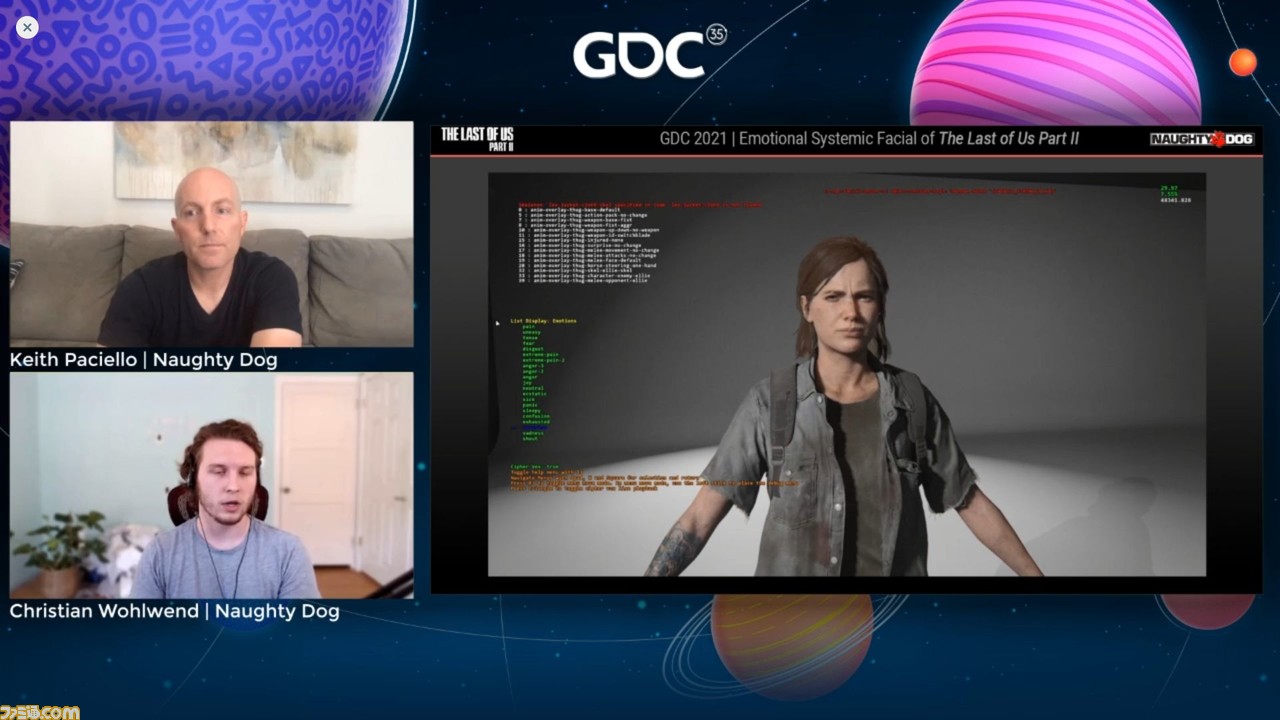

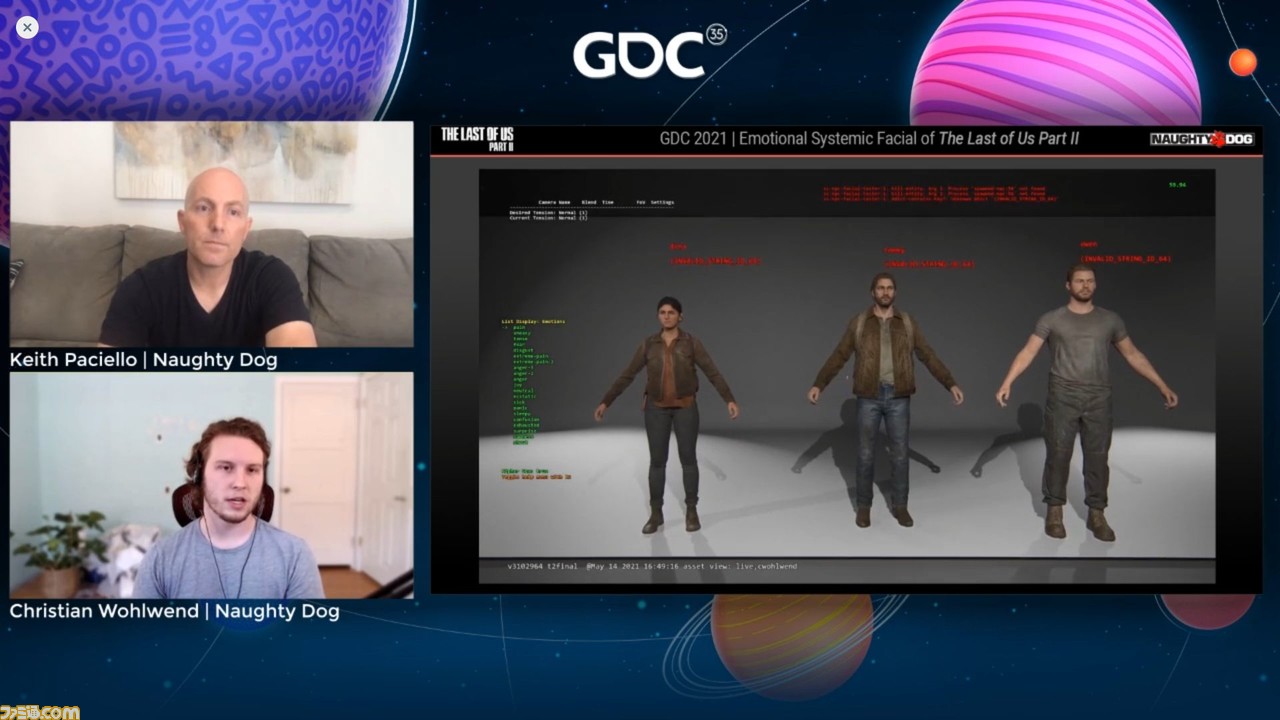

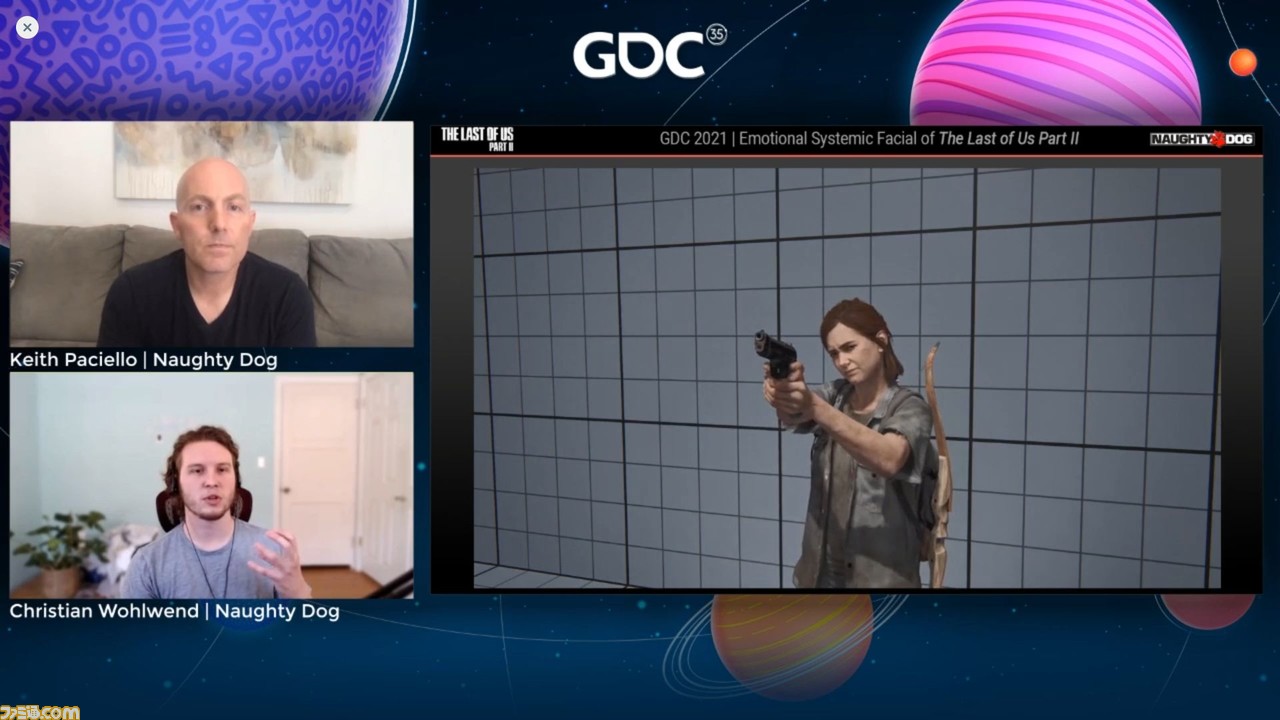

このようなボリュームのある作業には、多数の順列に対処できる堅牢なツールが必要だった。そこでフェイシャルテスターツールというものを開発した。これによってさまざまな感情のVOXラインの、素早いテストが可能になったという。ここで提示された動画(下記画像参照)は、エリーのCGモデルが同じVOXラインの遂行により、いくつかの感情を表しているものだ。

この機能によりMike Hourihan氏はフェイシャルテスターツールのサポートを追加し、Keith氏が望むVOXラインを指定し、VOXデータベースでプレイできるようにした。従ってゲームのどんなVOXラインもサポートして、このツールで再生できるようになり、改善したい箇所を見つけられるようになったのはすばらしい達成だったという。しかしこれはひとつのキャラクターについてのみの話である。実際は25のキーキャラクターがいて、民兵、男性、女性のベースに、各20もの異なる外観があるのだ。

このツールは複数のキャラクターのスポーンもサポートしている。それだけでなく、感情を配置し、その上にVOXラインを置くことを同時に行う。順列が非常に多く、同じ骨格を持っているように見えるたくさんのアクターがいることを考えると、これはとても重要なことだ。このツールをすべてのリグがこちらの望む通りの行動に見えるよう、動くことを保証するものとして使用する必要があった。とくに同じスケルトンがオーバーラップする外観では必要だったという。

フェイシャルシステムはこれに対処するため音素を分解し、VOXに基づいて決定している。これは多言語での動作が可能なので、ゲームがサポートする12の言語のテスティングツールで使用できる。

キャラクター数、感情の数を増やしたことで、彼らは自分たちが目指しているものの全体像が見えるようになった。しかし、当初からこのコンセプトがゲーム全体に適用できることを確実にしたいというひとつのゴールがあったが、これがかなりの難問だという事実もまた、ここにきて明らかになったのだという。

もし、もっと早い段階でこの状況に対応できていれば、それに沿ってパイプラインを構築することができたはずだ。しかしChristian氏たちは、すでにあるシステムにパイプラインを上乗せするような形でシステムを構築をすることになった。そしてここでのスタッフの努力により、ゲーム全体への適用は、問題なく可能になったという。

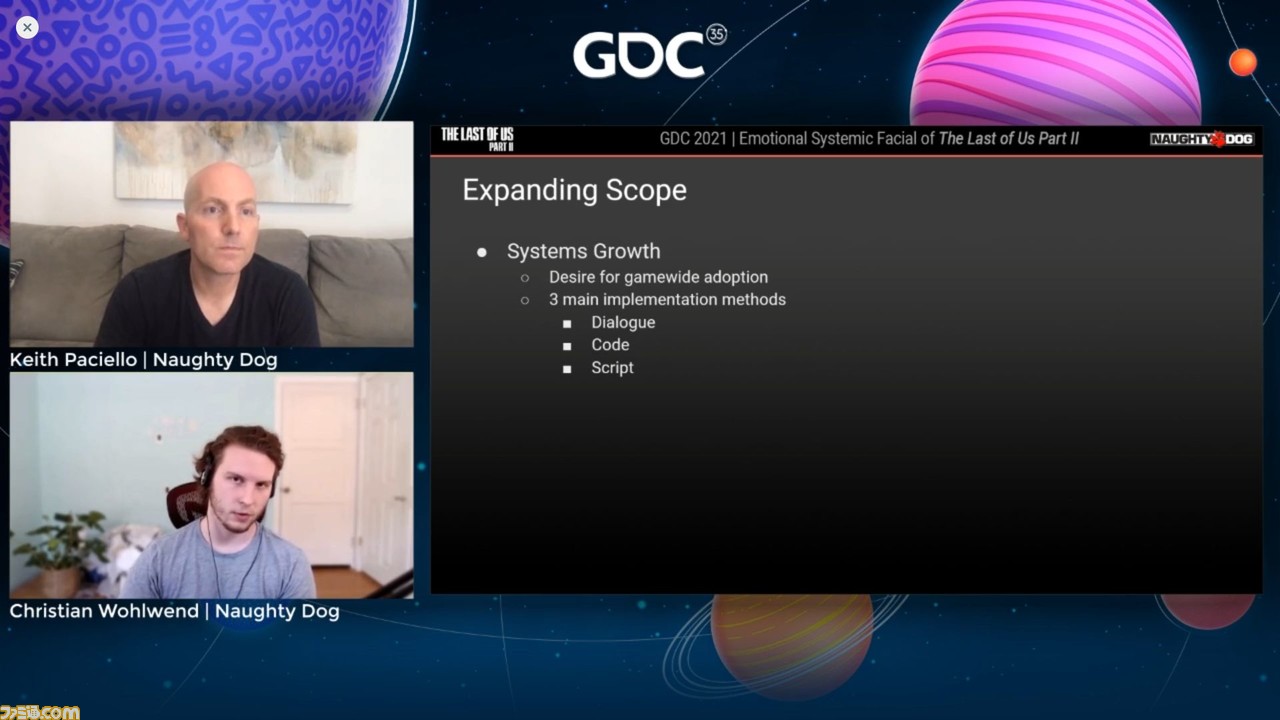

彼らはそのために、ダイアログ、コード、スクリプトという3つの主要な実装メソッドを開発した。

ダイアログ、コード、スクリプトについて

まずダイアログは、幅広く適用されるもので、ゲームで見られる実装の過半数を占める。

実際のパイプラインはかなり大きな投資となった。シンプルに見えるかもしれないが、そうではない。それでもやらなければならないと決めたのは、これらのVOXラインを実装する人たちが、実装時に感情を描く上での課題を達成することが必要だったからだ。

これは結果的に本作のライターがやることになったのだが、珍しいことだという。『ラスアス2』にはものすごい数のセリフがある。担当ではないから不正確かもしれないと断りつつも、10万以上の台詞が本作には入っているらしいと、Christian氏は語る。従って大規模事業になった。ライターが書いてゲームに実装する中、彼らは感情を持つものすべてをタグ付けしていった。

もちろんゴールはこれらの感情のカバレッジを、実際にゲームエンジン内で成り立たせることだ。25時間のキャンペーンのおよそ85%は、タグ付けしたセリフ上の感情をフィーチャーしている。残りの15%は100%のカバレッジにかなり近い。これはおそらくそのほかの実装メソッドを使っているとのこと。

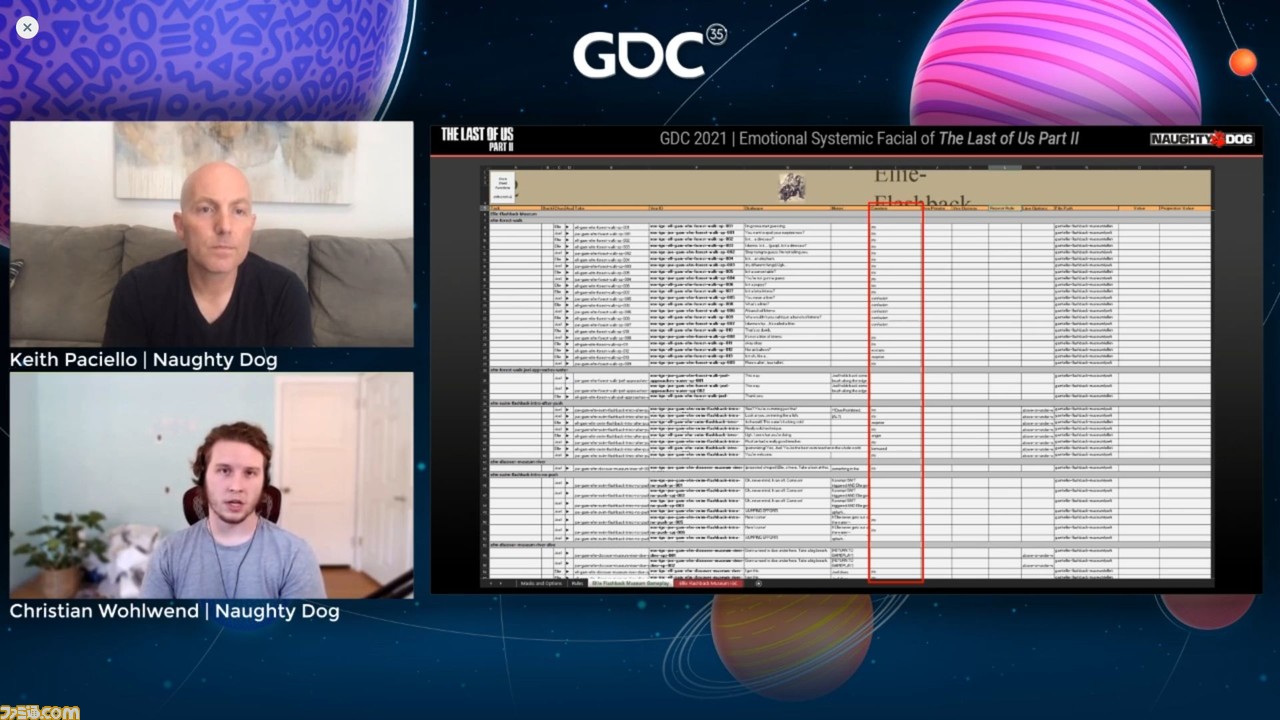

実際にどのように行ったのかを見てみよう。下の画像にあるのはゲームへの台詞のエクスポート用に使ったシート。多数使用したシートの中のひとつで、これによってすべてのVOXインジェストを処理したそうだ。画像の赤で囲んでいる部分が感情欄と呼んでいた部分。本質的にはドロップダウンボックスを入手したわけで、ここから台詞に入れたい感情を選べる。

このシートにはツールがあるので台詞を聞けば、どんな言いかたやパフォーマンスになっているのかがわかる。ぴったりの感情を選び、つぎに進む。非常にシンプルだ。

つぎの画像のアビーは重苦しいシーンでゆっくり話すところで、この時点でナラティブを推し進めるには特別な感情が必要だったが、VOXシートでの作業で十分対応できた。長所はとても素早く対応できることで、ベースライン実装のように始まり、多くのカバレッジが可能だという。

このコンセプトはとてもシンプルだと思うかもしれないが、プリプロダクションに入る彼らの立場を考えて、特別にデザインされた実装メソッドだった。

続いては、コードについて。ほとんどのプレイヤーシステムは、ある種のスクリプトタイプとして始まり、コードに移行する。そのシステムをサポートし続けたい場合はコードを変更する必要がある。そしてシステムがプロダクションに移行するとともに、彼らのコードでフェイシャル・チェンジをする必要があった。

プレイヤーキャラクターの移動、ロープ登り、銃撃などいくつかのシステムはコード主導で、最終的にはここでの実装は直接スクリプトから行われ、これは彼らがスクリプトでシステムを活かすためにやったことに似ている。しかし、ここではプログラマーと仕事をしているので少し違うパイプラインになるという。

多くの場合は実際の感情がどのように見えるか、どんなパフォーマンスを望んでいるかを知っているデザイナーやアニメーターと仕事をするのだが、ここではプログラマーと席をともにして彼らに何が起きるべきかを伝えることになる。多くの場合はゲーム内システムにおけるこれらの効果は微々たるものだが、それでもプログラマーたちは理解を示して、ゲームのトーンを設定してくれた。

いくつかの例を見てみよう。コードにおけるすばらしいフィーチャーのひとつに銃のエイミングにおけるフェイシャル・パフォーマンスがある。エリーはより集中して緊張感を持って樽を見下ろしているが、最後のほうでこれを解きつつ、徐々に顔を上げているのがわかる。また、転倒や落下のときは、地面にぶつかった痛みで顔をしかめる。坂を滑り降りるときは坂の終わりに近づくと恐怖に歪む表情が見られる。動画ではスローにして見せているが、これはすべてがとても早いスピードで変化しており、何が起きているのか肉眼でハッキリと把握することが困難だからだそうだ。しかし、そうして細部のリアリティーにこだわった結果は、必ず見る者の記憶に残るという。

続いてはスクリプトについて。これはもっとも汎用性の高い実装方法であり、非常にパワフルなツールのセットなので、多用することになったという。

いくつかのコンセプトがある。下の画像のブロックは博物館の回想中、VOXを制御しているスクリプトのスニペットである。彼らはVOXラインと感情を実装するにあたり限界があったことを説明したが、およそ1対1でVOXラインごとにひとつの感情がある。彼らがもっと何かやりたい、改善したいと思った場合に備えて編み出した方法は以下の通りだ。

ここでは手書きして、待って、プレイして、フラグを立てて、違うトラックの処理が完了するのを待っている状態を示している。少し強引なやりかたかもしれないが、すばらしいパイプラインはすでにデータに追加した所定の位置に設定されている。キャラクターがどこにいてほしいか、彼らがどのように待っているか、彼らどうしの会話など、あらゆる会話はジェスチャーとともにスクリプト化されている。

こうした工夫のおかげで彼らには時間の余裕ができ、手書きのフェイシャルルックを加えることができるようにしたという。下の画像では、右側に実際にリアルタイムでスクリプトが進んでいくのが見える。これは完全にシステムで動いており、アニメーターもIDCアニメーションも入っていない。単純に感情へとスクリプトが命令したジェスチャーが足されているだけだ。

これはオーディオ・インプリメンターのSean Lavalle氏が作ったものだ。かなり極端な例ではあるが、スクリプトのいいところはこのように彼らが望むだけ拡張可能という点にあるのだとか。

続いて、メレー(近接戦闘)時のスクリプトにある複雑なフェイシャルシステムについて説明する。このメレーシステムをChristian氏はたいへん気に入っているのだそう。メレー用のスクリプティングは、どんな外見とトーンにすべきか、そしてクオリティ・ベンチマークがどれくらいかは前作の経験からわかっていたという。

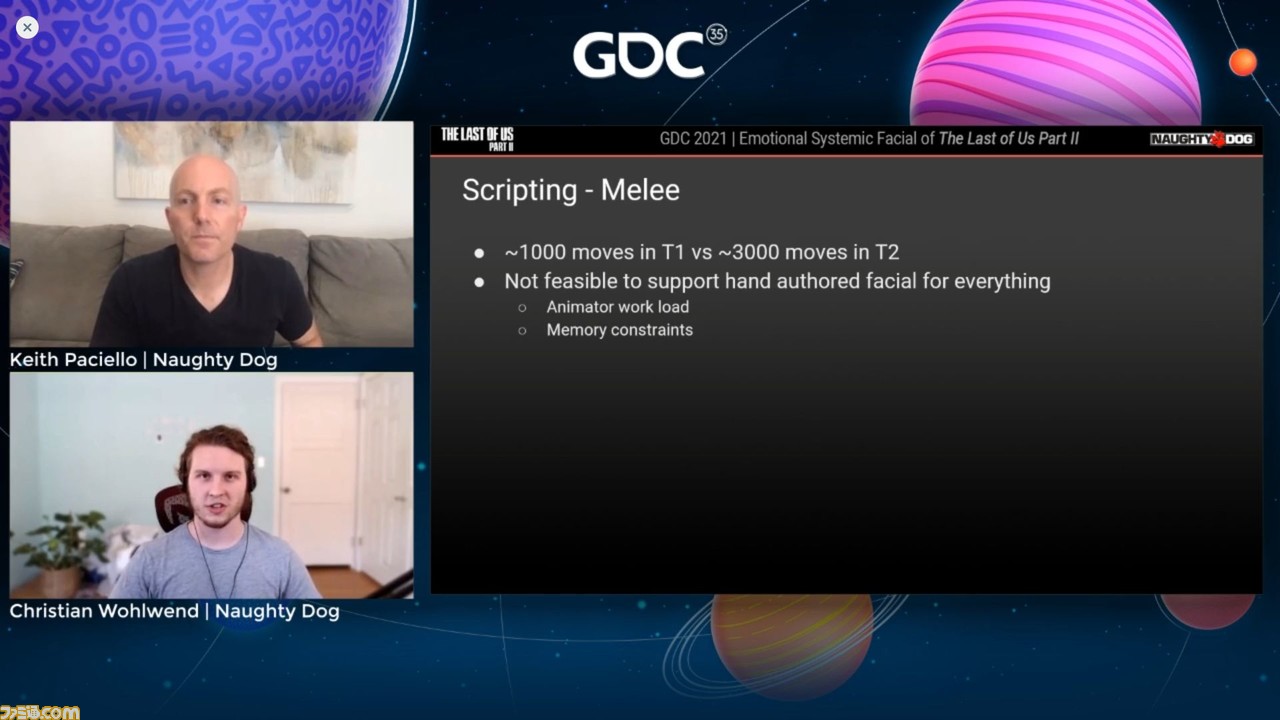

前作『ラスアス』ではムーブプールは比較的小さく、1000くらいのムーブがあった。特徴的なスタイルがあり、リグにはハンドキー・フェイシャルがたくさんあった。PS3はメモリ機能が非常に限られていたため、フェイシャルのための選択は非常に賢く行われたという。リグははるかに単純化されていたので、フェイシャル、メレー用ハンドオフの実際のコストは確実に低かった。

『ラスアス2』ではムーブの数が約3000、つまり3倍のコンテンツに対処することになった。一方、チームサイズは会社の方針で比較的小さく、経費節減策で進めている。このムーブコンテンツについてひとつ注意しておきたいのは、ムーブカウントのおよそ220個はフィニッシャー(とどめ)、80以上はプレイヤーデス(プレイヤーが操作するキャラクターの死)だったことだ。これらは非常に見栄えのよいものでなければいけない。誰かを倒したときや、自分自身が倒されたとき、プレイヤーは手応えや納得をほしがるものだ。見栄えを追求するため、カメラの視点も考える必要があった。

今作は、より複雑なリグを持っていることは確かだ。高い性能を持つPS4で開発してきたが、無制限にメモリがあるわけではない。しかし彼らはこのシステムで実行したかったオーサード・フェイシャルに関する問題に直面した。ひとつはこのビジョンを推し進めるには、アニメーターが不足していること、そしてもちろんメモリの制約だ。

エモーショナル・システムは正にこれに合ったものだと思った。だがすぐに導入したわけではない。ビデオゲームの開発ではよくあることだが、プロダクション半ばでキャラクターのフェイシャルを分析し、詳しく見ても、こちらはシステムにどっぷりフォーカスしているので、周囲のアクセサリーシステムなど役に立つものに目が行かない。そこでジェスチャー・システムを開発し、フェイシャルループを持つキャラクターの異なるレイヤーに、ジェスチャーを置いたりし始めた。これですべてが解決したわけではなかったが、希望するキャラクターの外観を反復することはできた。

さらにTravis氏から、「君たちが希望していた通りのものが作れたと思うので、このエモーションシステムをチェックしてみてほしい」と連絡があった。この時点で、メレーがどのようなものになるかを確認するためにエモーションシステムの導入を進めようということになり、結果的にとてもうまくいった。

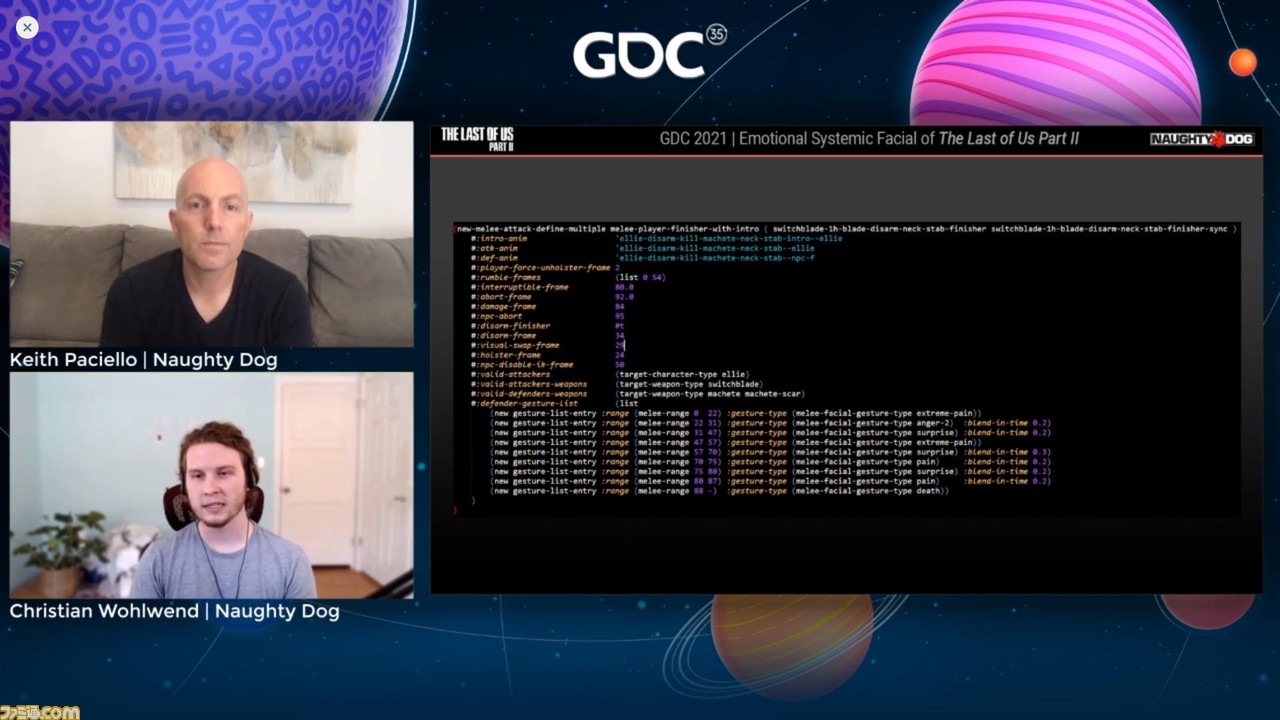

メレーについてもう少し見てみよう。これはメレーの定義。彼らのメレーシステムは個々のインスタンスを使って、これらの定義をマクロに基づいて継承する。オブジェクト指向言語であれば、マクロはクラスとして考えることができ、クラスのインスタンスとして定義できる。まったく同じではないがこれでよい。

ここでフォーカスしたい興味深い部分は、いちばん下にあるディフェンダー・ジェスチャーリストだという。ジェスチャーの命名規則は“ホールドオーバー(持ち越しの意味)”で、これは彼らが独自にいろいろやろうとしていた名残と言えるのだとか。

システムはマクロに基づいているので、入力したいさまざまな詳細レベルがある。最初はマクロレベルで、ジェスチャー用のデータを追加し、すべての個々の定義がエクスポートされるようにした。そしてそこからジェネリックにムーブの個々のすべてのクラスに適用するより見栄えよくするためのムーブを実際の定義で明確にできた。そのためにこのジェスチャーリストを使った。ジェスチャーリストは、ある範囲のフレームを取り入れるように、特別に作られている。

本作のメレーシステムでは、ほぼフレームで思考するため、フレームレンジを扱う。また、ジェスチャーにはタイプがある。感情をタイプに抽象化し、インスタンスによって素早くキャラクターの感情セットを変更できる。実際、これは後述するラストバトルで使われている。

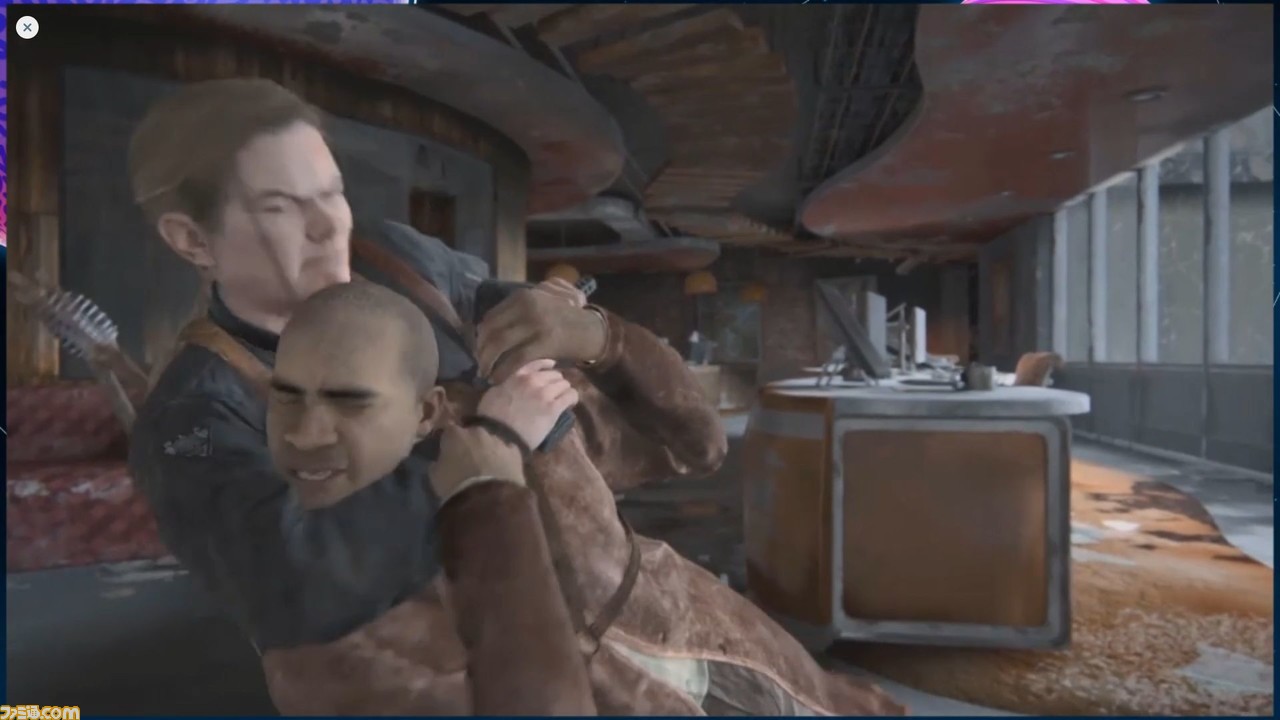

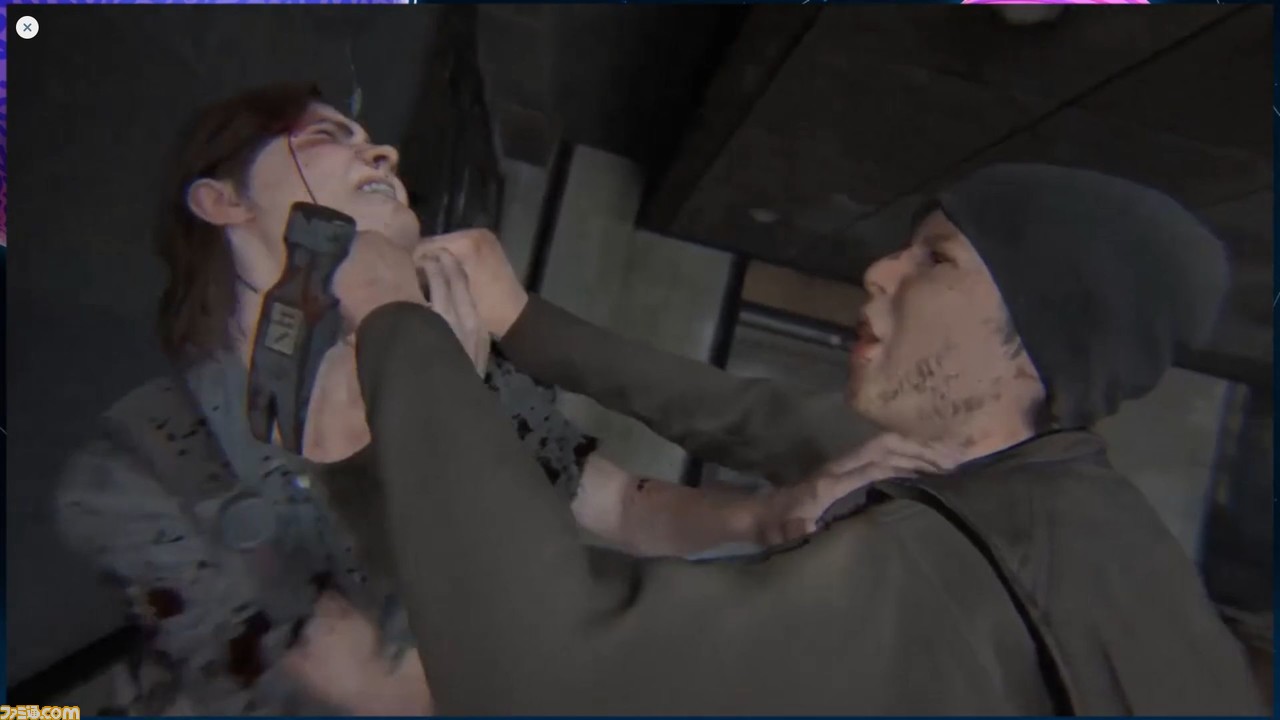

オプションのブレンドタイム、ホールドタイムを取り込み、詳細を見ると、たくさんの感情が生じていることがわかる。インゲームでこの例を見てみよう、とChristian氏。

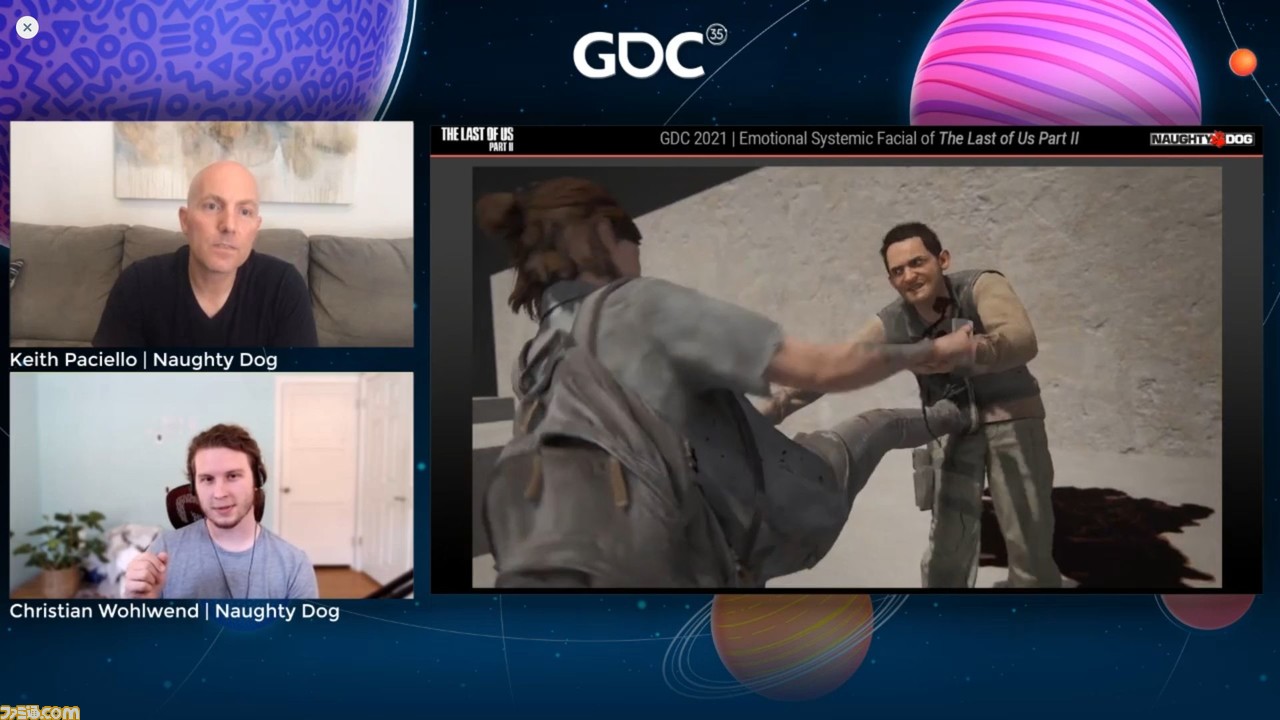

下の画像でエリーと対面しているNPCは、本作のデザイナーのひとりであるDaniel Harrison氏を模しているという。顔も実際の彼と非常に似ているとか。

スローモーションで観ると、Danielは刺される直前に、恐怖の表情を浮かべている。これはすべてスクリプト化されたフェイシャルだ。アナムフレームレンジを通して感情を指定し、タイムブレンディングを行って、アニメーターはフェイシャルリグに全く触れていない。ジョイントはチェックされず、メモリをセーブし、手間を省いている。そこにたどり着くまでの時間をスクリプト化しているのだとか。

これが実際に可能であることを証明するために、ちょっとしたおもしろいものを見せるというChristian氏。これらの感情をすべてスワップし、喜びの感情を与える。すると、今度のDanielは刺される直前、少し微笑みの表情を浮かべたのだ。

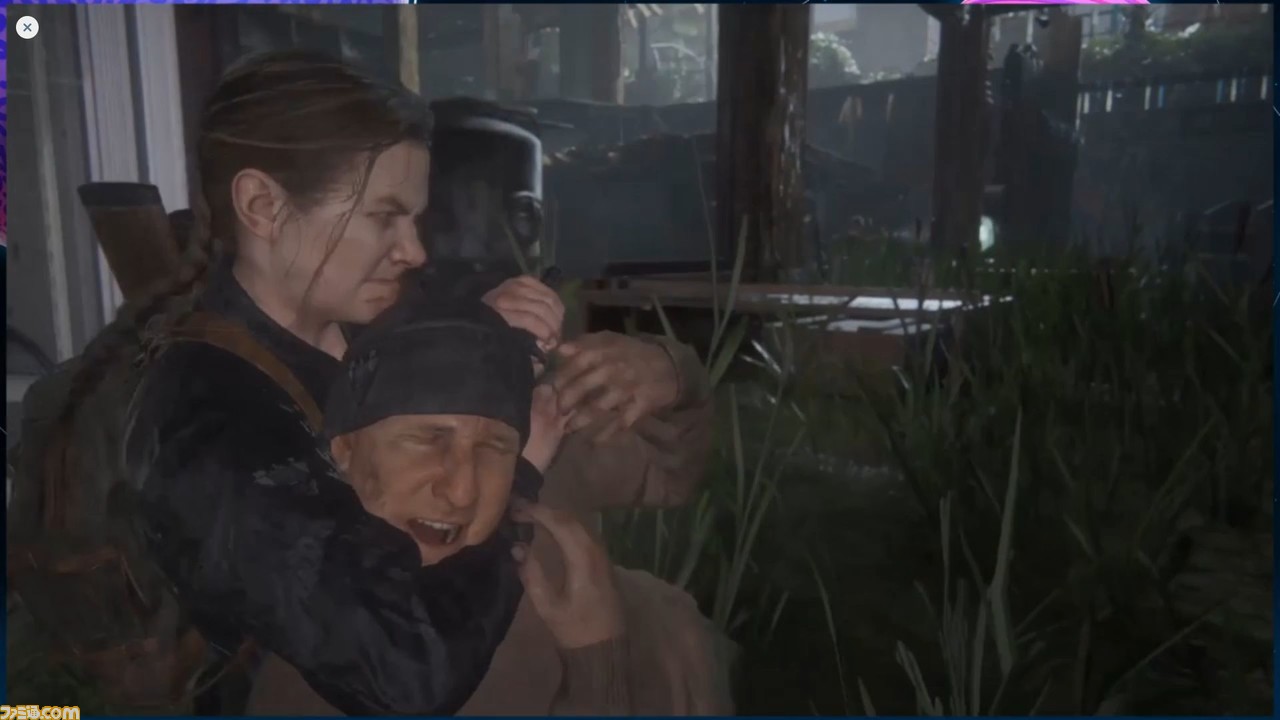

メレーにおけるフェイシャルシステムでは、フィニッシャーだけではなく多くのコンテンツを作ったので、そのモンタージュを見てみよう、とChristian氏。スライドには、いくつかのシチュエーションの戦闘シーンの動画が流される。

これまでアニメーターチームで実現不可能だったことについてスマートな実装を行うことで、全体を取りまとめることができ、効率のよい仕事になったと思うと、Christian氏は自分とKeith氏の仕事を評価した。

ほかにもシステミックフェイシャルを使っているいくつかのシステムがあるという。ヒット・リアクションはさまざまな感情の反復を定義するために使われる。NPCどうしの戦いもメレーシステムの一部であり、三人称視点からのフェイシャルもよいものに仕上がったとのこと。

細かいディテールについて

ここまで、ハイレベルのコンセプトとデザイン、タスクの範囲、またシステムを実装するおもな方法について話してきた。しかし、これはノーティードッグをノーティードッグたらしめているものではないという。ナラティブと歩調を合わせるため、キャラクターの手首にタイムコレクトウォッチを実装し、タイムアキュレートポイントをリセットした。フェイシャルはノーティードッグのポテンシャルを豊かにしてくれるコンセプトである。ここから、先の段階へ進もう、とKeith氏。

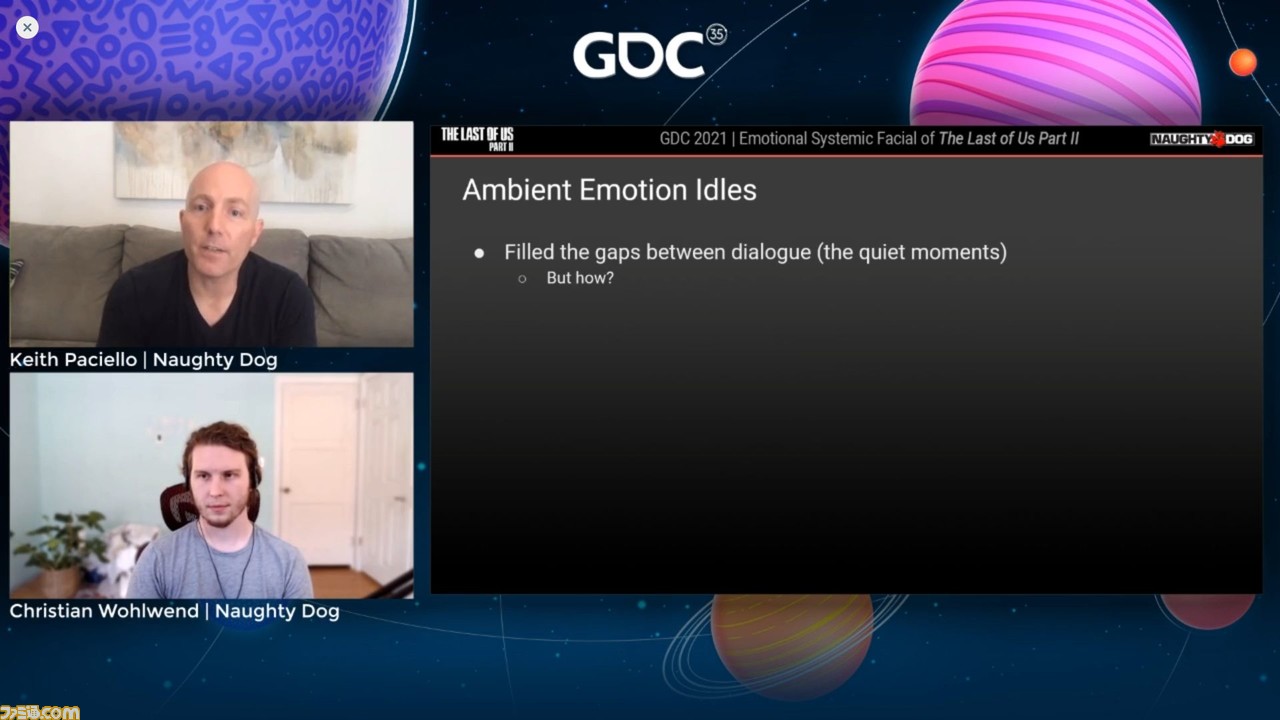

まず解説したのは、アンビエント・エモーション・アイドルという概念。この時点でゲームにはエモーショナルタグが付けられたダイアログがあり、エモーショナルにテクスチャー加工されたメレーが入っている。しかしカバレッジにはまだギャップが残されている。それは“静かな瞬間”だという。ゲーム内には会話やつぶやきといった言語情報のない、感情とナラティブの構成要素だけで完全に満たされている状況がある。そうした状況を自然なものにするにはどうすべきか?

この状況とは要するに前述したニュートラル、不安、戦闘の3つのアイドル(いずれにも含まれない状況)である。これは過去のゲームにもあった。この3つのアイドルはそれぞれ2000〜3000のフレームアニメーションループで作られている。しかし今作ではキャラクターが15〜20の感情を持つので、キャラクターがゲームプレイを通して静かに進んでいるあいだ、ナラティブストーリーの構成要素に密接にマッチさせるため、ゲームプレイ中の任意の時点で、アイドルであってもこれらの感情のいずれかにアクセスできるようにしたかった。

メモリフットプリントについて意識的に考えるよう努力した。しかしこれを考慮すると、15〜20の感情を持つ2000〜3000フレームのフェイシャルアイドルは扱えなかった。そこでKeith氏はアニメートするときによく使う、オフセットレイヤーを使用した。フェイシャルシステムが追加された状態では喜びのような特定の感情のニュートラルフレームを外し、それをニュートラルなアンビエントアイドルの上に乗せることができるはずだと考えた。そしてそれはキープアライブとしてアンビエントを使い、新しい喜びのアイドルを生み出す。これを試したところうまくいったという。

希望する感情で新しいアイドルを作成するために、ニュートラルアイドル上に加算として各感情から1フレーム分のニュートラルを利用し、メモリには事実上何も追加しない。ゲームプレイの特定の瞬間が、キャラクターにとってどんな違いがあるか見てみようといい、3パターンの動画を比較(下の画像参照)。

これはニュートラルなアイドルと感情的なアイドルを比較したものだ。アンビエントエモーショナルアイドルはキャラクターを地に足の着いたものに感じさせ、プレイヤーの没入感に大いに役立った。左のふたつの画像を比べると、微妙な笑顔だけで見えかたに大きな違いを生むことがわかったとのこと。また右のふたつの画像ではさらに大きな違いがあり、これは目の方向である。これについては後ほど話す。

異なる範囲の感情的アイドルを追加したことで、ゲームプレイを通じてブレンドインとアウトだけでなく、ムービーシーンにもシームレスに、ナラティブ構成要素にいっそう密接にマッチする感情をキャラクターへとペースアウトすることができたという。

続いて解説は、何人ものキャラクターがゲーム内で顔に装着するガスマスクのことに移った。顔の表情の少なくない部分が見えなくなってしまうガスマスク装着時のために、見えている部分だけでも感情が把握しやすいように、顔の上部の微調整を行ったのだという。

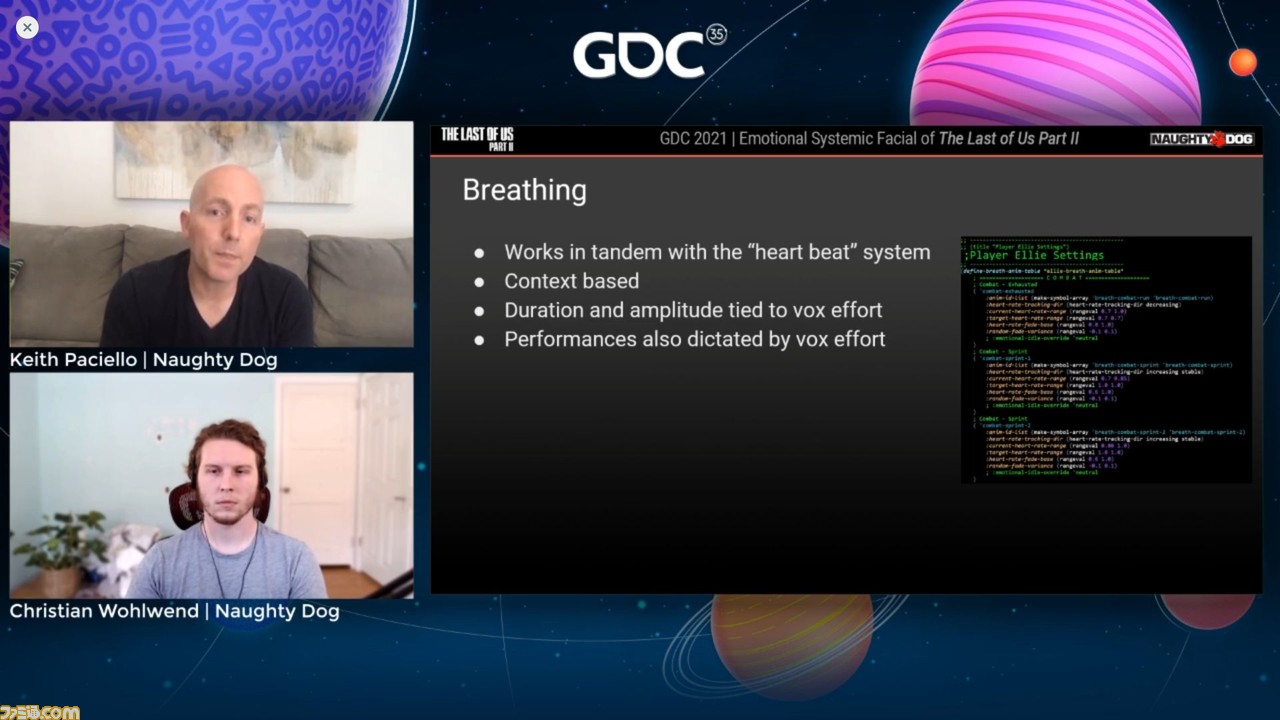

これはKeith氏が、もっとも気に入っているフェイシャルシステムへの追加機能のひとつなのだとか。Keith氏はシステムの開発に貢献した、プログラマーのEli Omernick氏、サウンドデザイナーのBeau Jimenez氏への感謝を表明した。Keith氏は彼らのオフィスに呼ばれて、ふたりが取り組んでいた音声呼吸システムをアニメーションサポートできるかと聞かれた。ふたりの話には本当に驚いたという。即座にアニメーションによってこれをサポートする必要があると思った。

呼吸は心臓の鼓動のシステムによって起こされているが、これはプレイヤーのアクションやコンテキストによってモジュレートされているという。この場合の心臓の鼓動は、どれだけ冷静に、あるいは積極的に行動するかで決まるという。しかしこれは人間の実際の呼吸を深く考慮したものではなかった。同じように静かに行動していても、疲労しているときと、ただ静かにしていようと思うときでは呼吸のしかたは違うのだ。

呼吸システムにはブレステーブルというものがあり、彼らが望む呼吸アニメーションを設定でき、VOXもパフォーマンスを指示するために設定されるという。特定の呼吸アニメーションで、呼吸システムがオーディオブレスを動かすと、キャラクターの奥深さがこれまで見たことのないレベルに達した。

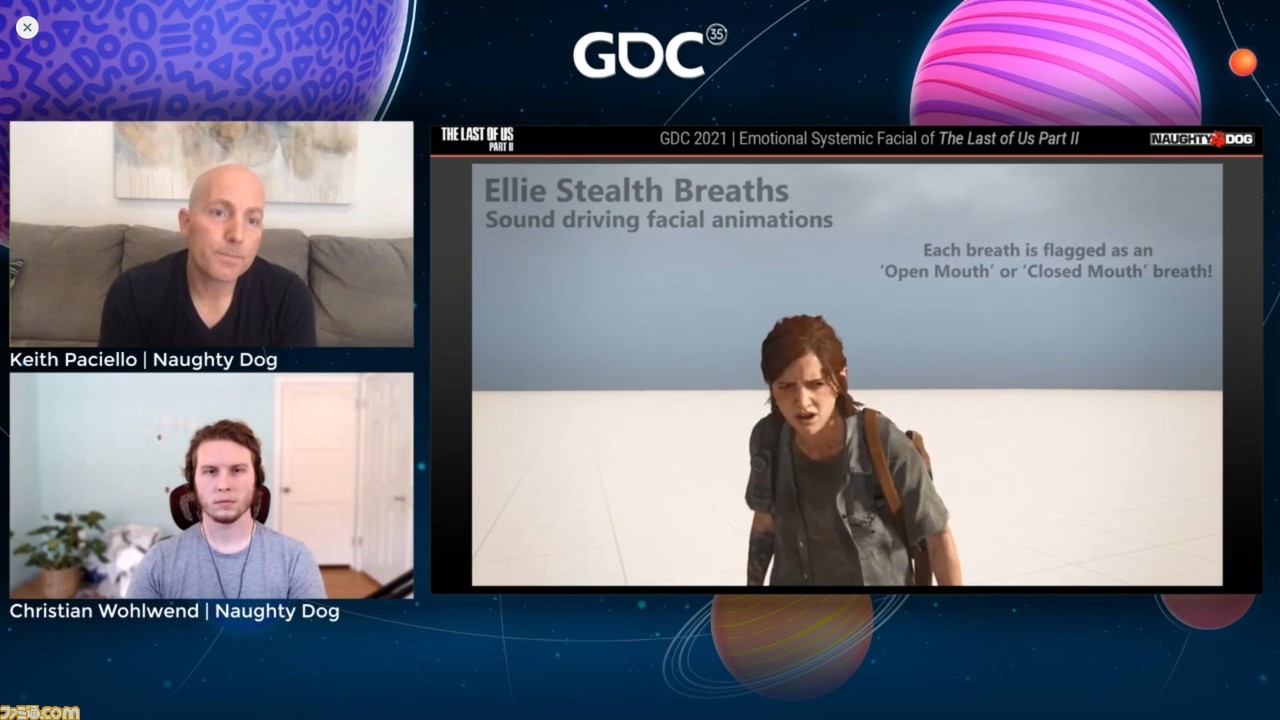

下の画像は呼吸をするエリーのビデオクリップの一場面だ。ここでエリーは、口を閉じ、そして開き、疲れて吸ったり吐いたりしている。そして回復し始め、鼓動が落ち着くとニュートラルに戻る。

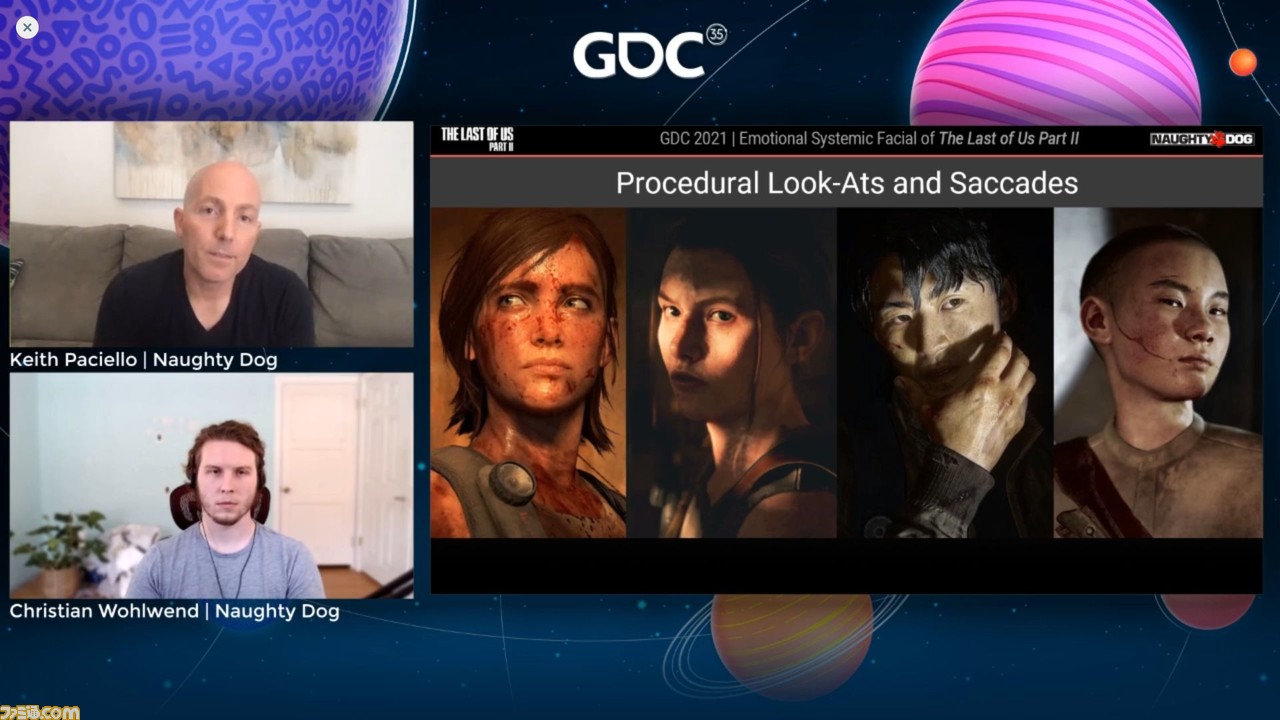

私たちは人の目をよく見るだけでその人のいろいろなことがわかることがある。彼らはゲーム内のキャラクターでもそのクオリティを捉えたいと思った。そうKeith氏は語った。下の画像では、これらのキャラクターの中で思考プロセスが進んでいることがわかるだろう。彼らの目にフォーカスしていなければ、こうした感情の伝達は失敗するという。これを成功させるため、サカディック・アニメーションと、プロシージャルルックアット・システムというふたつのツールをミックスしたそうだ。

全体におけるキャラクターの目のシステムは、リードアニメーターのMichal Mach、そしてプリンシプル・プログラマーのJohn Bellamyが担当した。更新されたフェイシャル・システムがクラシック・フェイシャルアニメーションを個々のレイヤーに分解。コントロールしやすく、バリエーションを増やすためにすべてのレイヤーは別々に制御された。

周囲を警戒している場合、目が真っ先に動いて、そのつぎが頭、それから身体が動くといった順番になる。こうした自然な動きも、レイヤーを個別に制御したことで、達成されたという。断続的な体の動きについては、目がターゲットを絞っていると小さくなり、視点が散漫なときは大きくてバタバタした動きにした。

NPCだけがこうしたプロシージャルの警戒の機能を持っており、プレイヤーキャラクターは持っていない。それはプレイヤーキャラクターは、エイミングをはじめ、プレイヤーの意識に紐付いているからだ。ここで紹介されたビデオではプロシージャルルックアットが自然に頭と身体を動かしている。ヘッドターン時に点滅しているのも見える。そしてまぶたが開いたときには目はすでに必要なところへエイミングしている。フェイシャルアニメーションがどれだけ使われているかや感情的ポーズもあるが、ここでは完全に目でわかるので必要ない。

下の画像に示されている動画でエリーは、顔、目、体が一斉に運動し、ひとつのパフォーマンスを形成している。フェイシャルには疲れた感情的なポーズがニュートラルアイドルの上に乗っており、特定の呼吸が呼吸システムから呼び出されて上乗せされている。これは彼らがスタートに立った際の大きなゴールだったという。すべてが現実のものになるところを見るのはすばらししかったと語った。

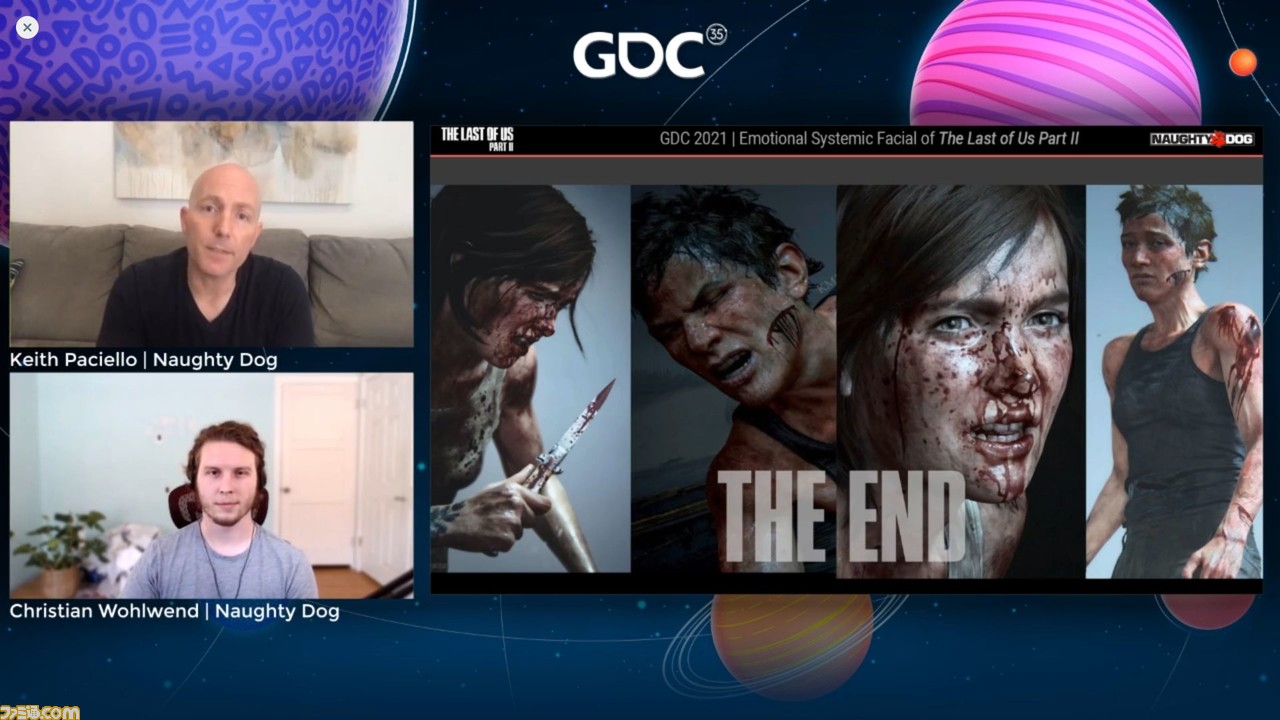

ラストバトル(ネタバレ注意!)

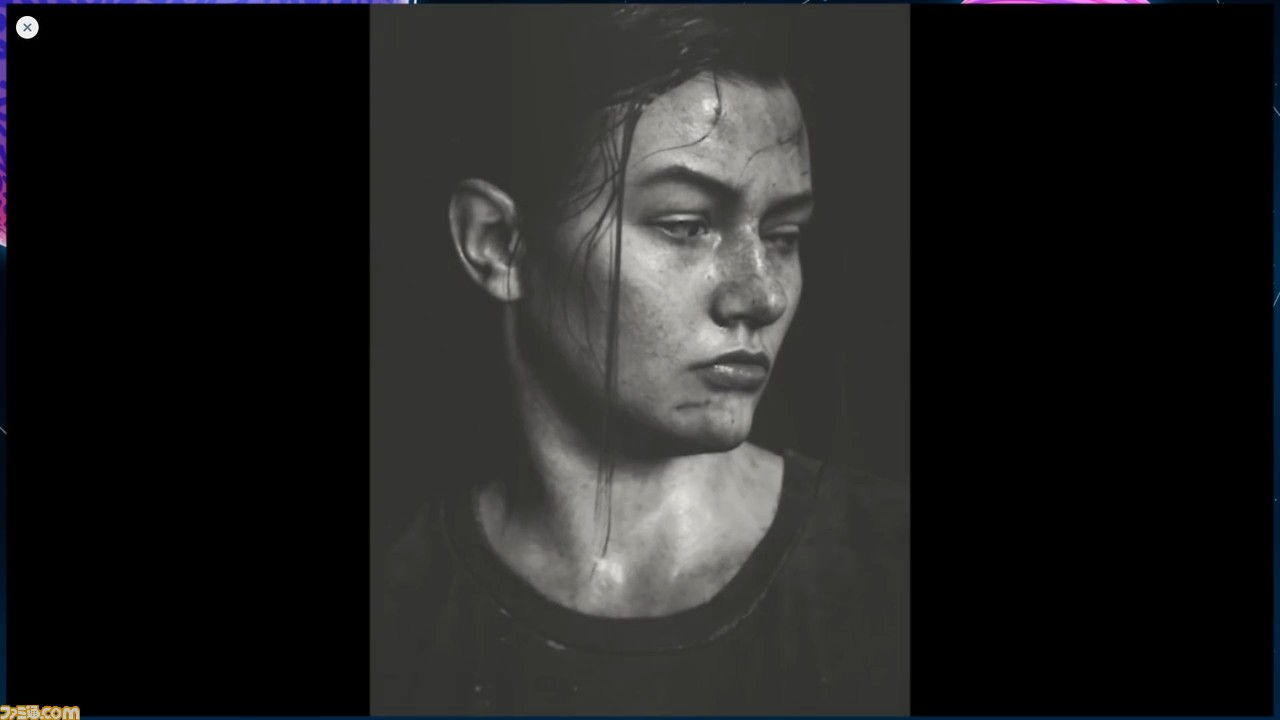

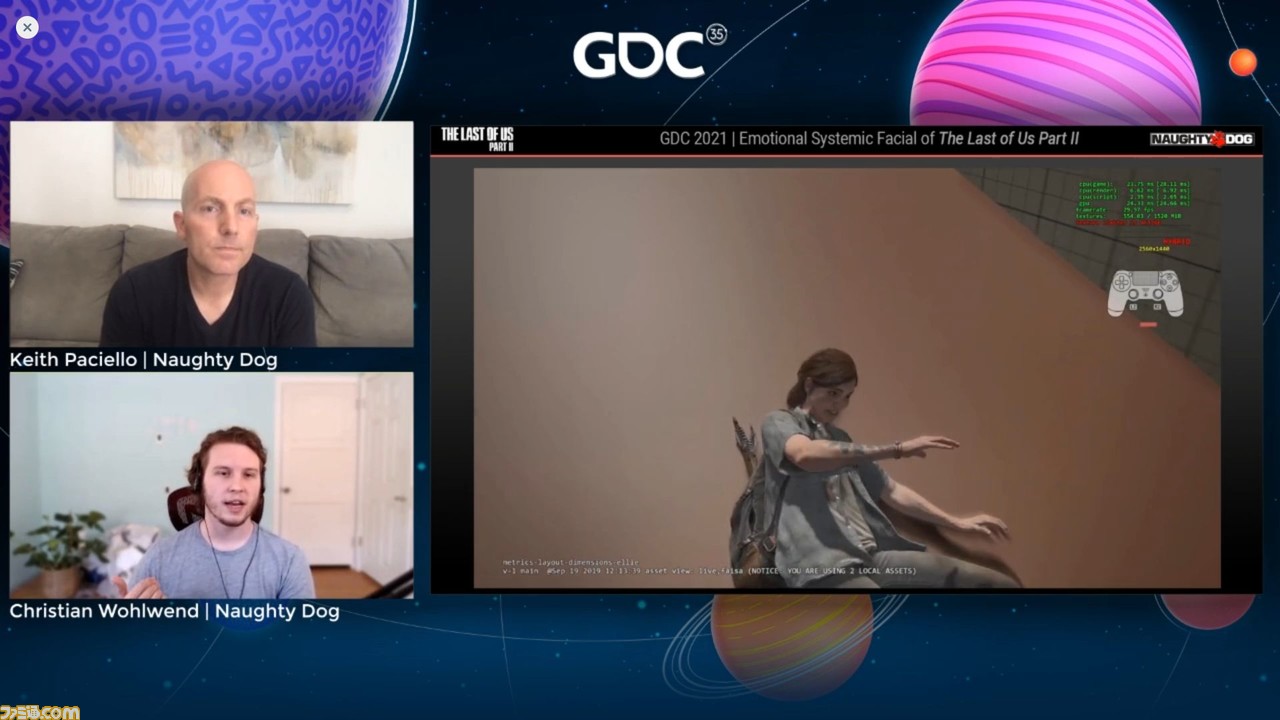

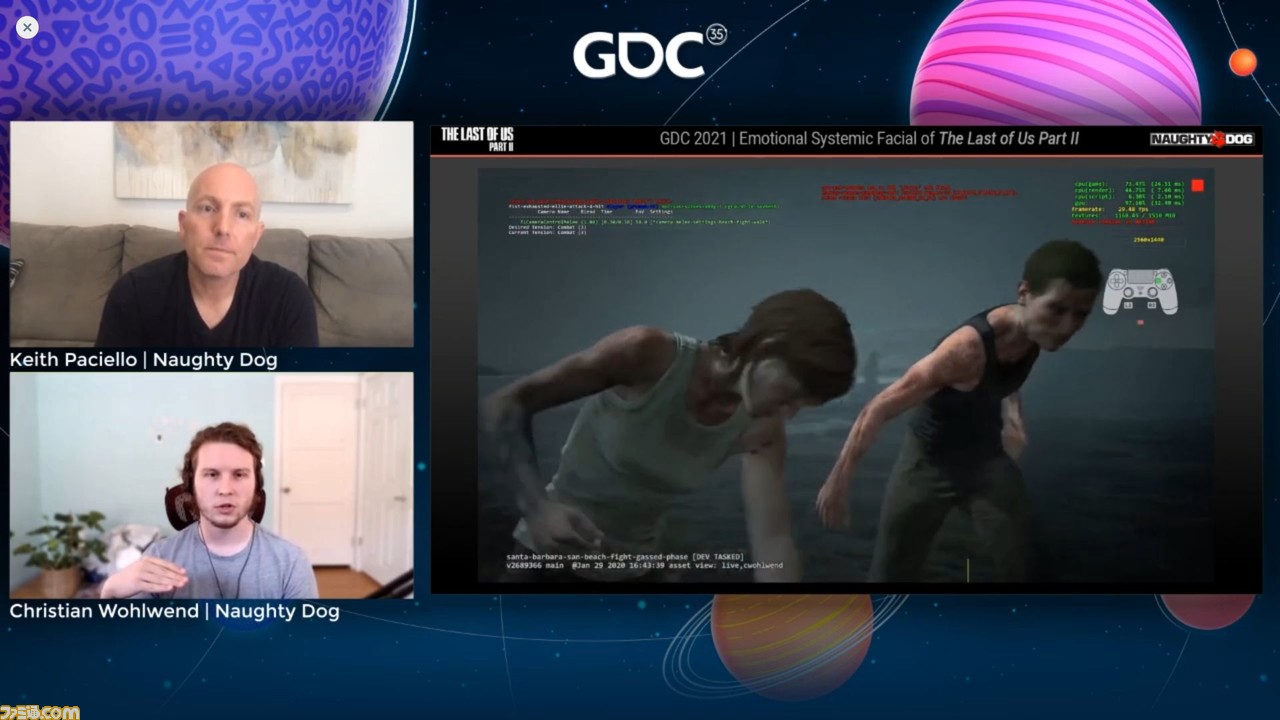

ここからは、ゲームのクライマックスにおける海岸での戦いのことが語られた。当初、このラストバトルについてはあまり知らされておらず、ゲームのクライマックスであり、この直前までアビーは吊るされており、衰弱しているという情報だけが与えられていたという。Keith氏はすぐにこのファイトアウトをテストし始めた。アビーの顔がゲーム全体を通して同じであり、激しい顔であることに気づいた。そしてそれはナラティブの構成要素に合致していないと感じたとのこと。

Keith氏はすぐにChristian氏にトライしたいアイデアがあると話した。彼はアビーのメレー・フェイシャル全体を重複させて、各音素セットに疲労の層を追加するつもりだった。これはテストとして行おうとしたもので、これが正しいやりかたかどうか知りたかったという。

この(Keith氏たちにとっての)戦いの始まりは、かなり謙虚なものだった。上の画像で再生されている動画はかなり開発初期の段階のクリップだが、初期の印象ではゲームプレイのフォーカスタッチは精彩を欠いていた。このファイトでのキャラクターの感情は、プレイヤーに響かないものだったのだとか。

そこでKeith氏が感情のためにいくつかのアセットを提供し、Christian氏たちはそれを実装し始めた。そして最終的には、システミックフェイシャルシステムが提供するものをすべてねじ曲げることになった。それはこれらのキャラクターが、戦っているときにどのように見え、行動し、感じているかを完全に絞り込むのは正しくないと判断したからだ。これはエリーとアビーにとってとても重要な瞬間なのだから、さまざまな感情が入り乱れて当然のはずである、ということだろう。

この試行錯誤が実った手応えをChristian氏が感じたのは、アビーの以下の画像の表情を確認したときだったという。

この瞬間、アビーにはもはや激しい敵意は残っていないことがわかり、同情心さえ沸いてくる。多分彼女はもうここに居たくない。あるいはこの瞬間、彼女の感情としては、この戦いに何の意味も見い出せていないのだろうということが、表情だけで伝わってくる。

この虚しさすら感じられるクライマックスの戦いこそが、彼らが『ラスアス2』に関わって学んだことすべての集大成だったという。

※画像は配信をキャプチャーしたものです。